Qarrion

Profi

- Mitglied seit

- 25.02.2021

- Beiträge

- 173

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 9800X3D

- Mainboard

- Asus ProArt X670E Creator

- Kühler

- Alphacool Eisblock

- Speicher

- 2x24GB DDR5 6400 CL32

- Grafikprozessor

- RTX 4090 Founders Edition

- Display

- Samsung Odyssey G9 5120x1440 @ 240Hz

- SSD

- 2x 4TB Samsung 990 Pro

- Gehäuse

- Thermaltake View TG 71

- Netzteil

- Bequiet 1500W Titanium

- Internet

- ▼↓ 1096Mb/s ▲↑ 54,8Mb/s

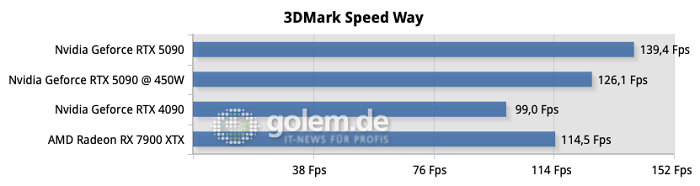

Die 5090 ist wohl in 4K native ohne RT massiv CPU limitiert, selbst mit dem 9800x3d

Bei 8k ~50% uplift:

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Bei 8k ~50% uplift:

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen