Die Ideen hier sind super, wie man bis ins letzte Detail versuchen möchte, die Effizienz zu vergleichen, aber eine saubere statistische Analyse eines A/B-Vergleichs für die Ergebnisaussage A oder B ist signifikant besser (und in was überhaupt), der muss schon recht weit ausholen (T-Tests, Analyse konfundierender Variablen, Gauss-Verteilung, kritische Effektgröße, usw...), und selbst bei den Impfstoffen des uns alle abnervenden Themas habe ich noch keine Studie gesehen, die auf dem Niveau der Verleihung eines Doktorgrades Dr. rer. Nat. durchgezogen wurde.

Zurück zum Thema Intel und Effizienz:

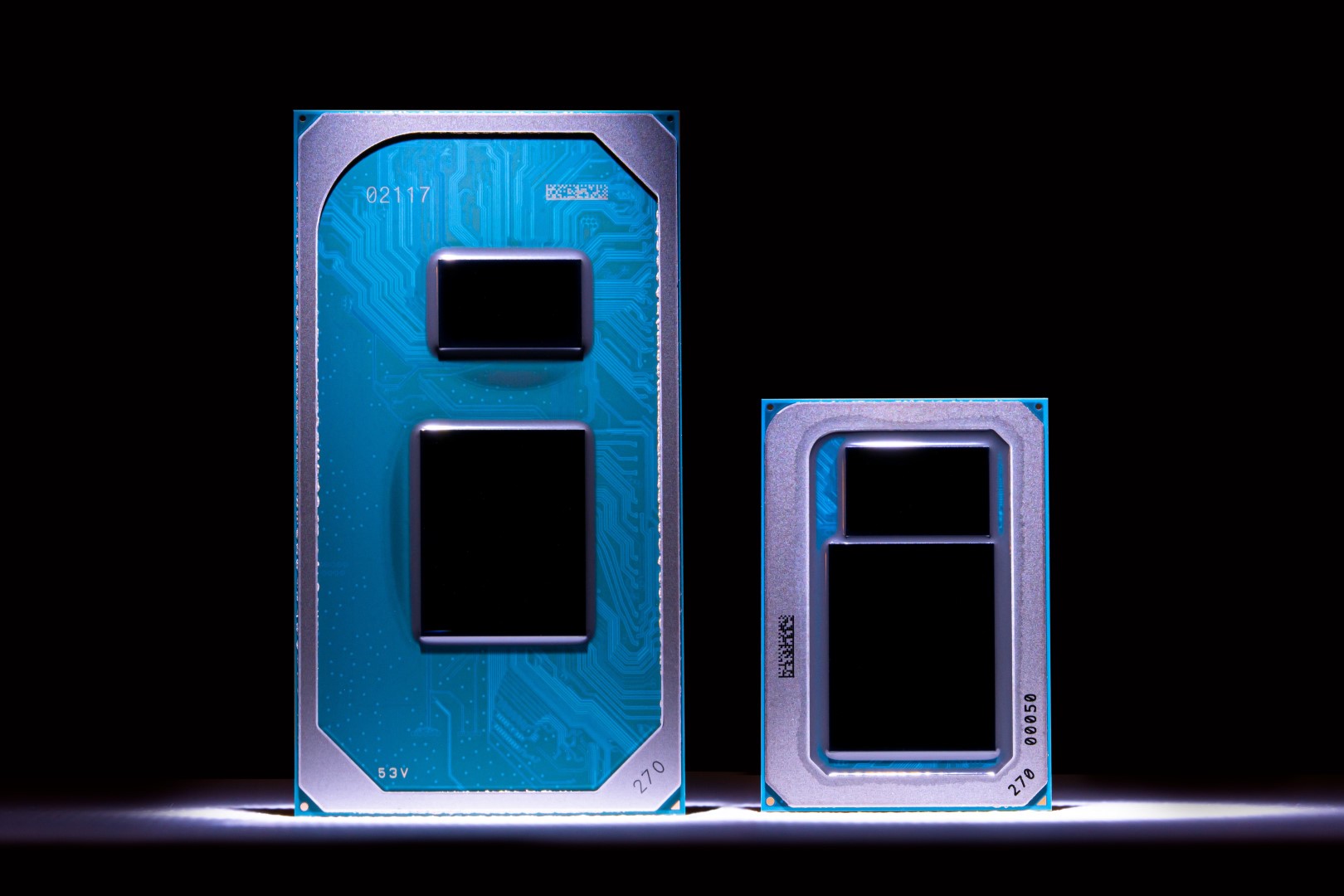

Es steht denke ich außer Frage, dass es eine große Menge von Anwendungsfällen gibt, bei dem der neue Intel all seinen Vorgängerversionen und auch ganz sicher den ZEN3 überlegen ist. Zusammenfassende Ergebnisse sind dabei leider auch irreführend, weil die Gewichtung der Einzeltest nicht unbedingt das jeweilige Anwendungsszenario des einzelnen Users ist. Dennoch: es weht wieder Wind durch den Markt, denn das belebt die Konkurrenz zwischen den Herstellern. Was aber absoluter Murx ist: Benchergebnisse, die teilweise (nicht alle) überzogen Intel selbst in der Paradedisziplin von AMDs 5950x "Multithread-rendering" auf Augenhöhe sahen und dabei weltfremde niedrige Benchergebnisse für den AMD in den Vergleich einbinden und als schönes Beispiel; bei einem blender Test von Linus Tech Tips wurde tatsächlich auch die anliegende Leistung am 12900K über den Zeitraum gezeigt. Und wenn man genau dieses Szenario auf einen 5950x losläßt, aufgrund des Chiplottos und eventuell besseren Boards am AMD sogar "nur" ~200W anlegt und gegen den (in diesem speziellen Test) dauerhaft bratenden ~240W von Intel vergleicht, der endet damit, dass der 5950X (in dieser Disziplin) ~40%schneller ist. Da ist nunmal die noch immer nicht zu AMD auf Augenhöhe liegende Fertigungsproblematik in 10 vs 7nm Strukturgröße. Und genau das macht dann viele andere Testergebnisse fraglich, wie vergleichbar das Ergebnis nun war. Und da bleibt es dann nicht nur bei blender, es sind praktisch alle Multicore-Benchmarks, die länger als ein paar Sekunden gehen.

Letzten Endes haben aber diese Reviews, die teils den faden Beigeschmack von bezahlten Influenzern tragen, immerhin gezeigt, worauf man achten muss und wie komplex inzwischen das Thema "welchen neuen Rechner kaufe ich denn nun" geworden ist, wenn man es als Endanwender genau wissen will. Für eine oberflächliche Betrachtung reicht es aber: Will ich mit dem PC zocken, dann nehme ich aktuell den neuen Intel und: es muss definitiv nicht das dickste Ding mit Brechstange sein.