Eben, so sehe ich das auch, denn wer immer wieder Aussagen macht die nicht belegt sind und sich als falsch herausstellen, dann aber im schlimmsten Whataboutism mit der falschen Behauptung kommt, ist kein Diskussionspartner.

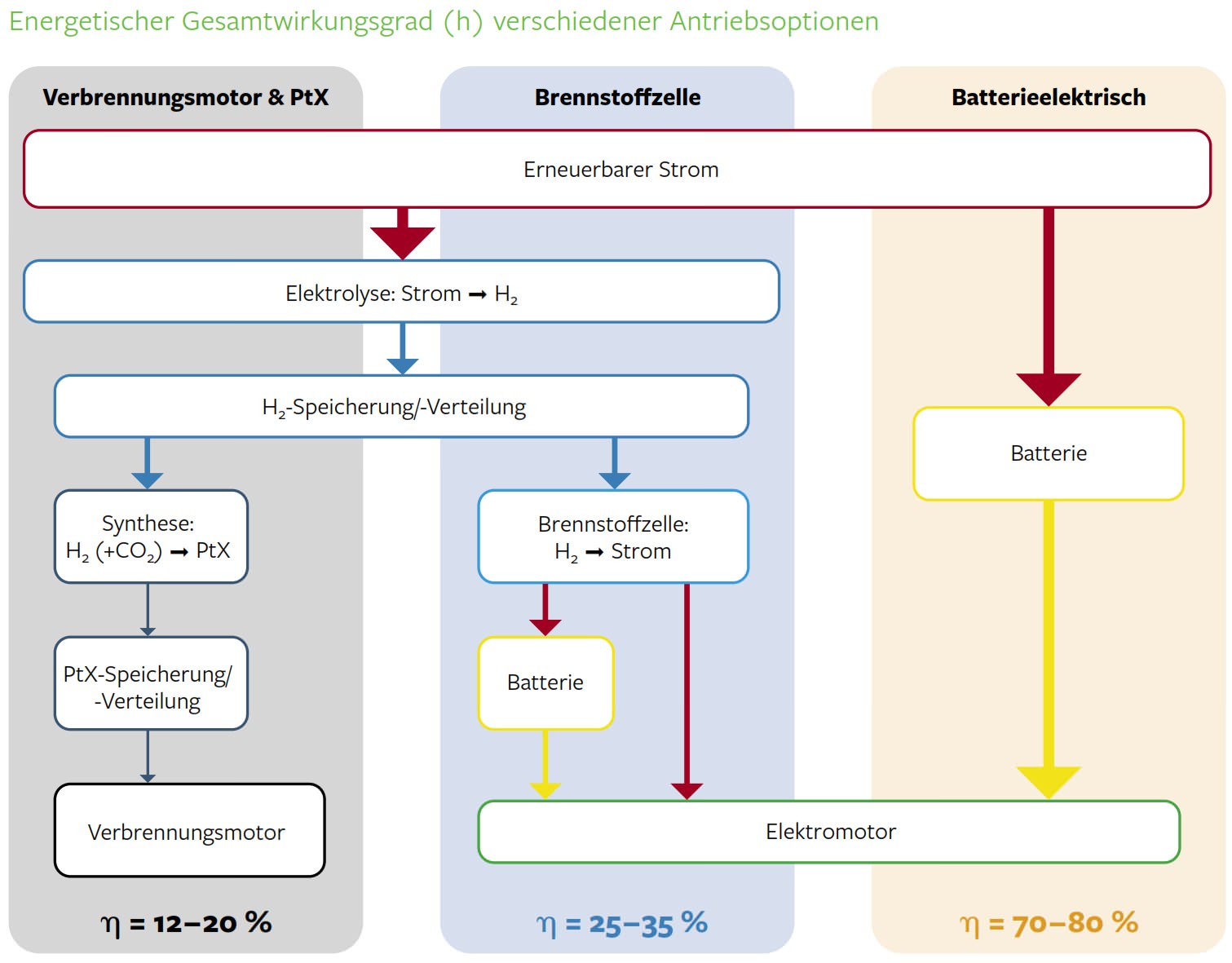

Eben du hast weder meine Informationsquellen zum Wirkungsgrad gelesen noch hast du dich mit deiner eigenen Studie auseinandergesetzt, den Passus das man für 50% Wirkungsgrad unter anderem synthetische Kraftstoffe brauch wurde einfach überlesen und das man dort nur Entwicklungen wieder vorantreibt weil man spontan von alternativen Antrieben recht zügig überholt wird darf man auch nicht vergessen.

Um zum Fahrzeug zurück zu kommen, es hat sich am Motor nach wie vor nichts verbessert.

Alles zielt auf den Kraftstoff und das drum herum.

Also, vor 40 Jahren hatte ich einen Mercedes 200D /8 - 55PS, Höchstgeschwindigkeit 130 km/h, 26 sec. von 0 auf 100. Verbrauch bei 130 geschätzt 12l/100 km. Mein heutiger Diesel beschleunigt gut 5x so schnell, die Höchstgeschwindigkeit ist ca. doppelt so hoch und obwohl er eine Tonne mehr wiegt als der 200D, verbraucht er bei 130 ca. 7,5 l/100km. Heerscharen von Ingenieuren haben in den letzten Jahrzehnten daran gearbeitet, Motoren stärker, effizienter und sauberer zu machen - mit Erfolg.

Es haben sich die technischen Errungenschaften herum verbessert am Antrieb/Fahrzeug, wie z. B Reduktion der Gesamtmasse des Fahrzeugs, intelligentere Steuerungen usw. Aber der Motor selbst, das Funktionsprinzip da ist nix besser geworden. - nicht zu vergessen der Strömungswiderstand. Es sind alles Errungenschaften dank Materialforschung auch die Reifen sind besser geworden mit niedrigerem Rollwiderstand die Übertragung an der Achse usw. diese ganzen Dinge in Kombination haben zur Verbesserung der Werte insgesamt geführt.. aber wie man eben auch in den letzten Jahren am Dieselgate gesehen hatte, scheinen die Werte nicht alle so glaubhaft zu sein wie sie sollten.

Neue Instruktionen zu erstellen, ist aber ein Mittel, um die IPC zu steigern. Die Steigerung der IPC bei AMD resultiert u.a auch aus der Überarbeitung der AVX Register. AMD hat bei Zen die AVX2 Leistung noch verkrüppelt, da man dort auf 2*128 Bit Register gesetzt hat, anstatt auf 256 Bit Register. Erst seit Zen2 setzt AMD auch auf 256 Bit Register.

Das mag richtig sein, aber das hat zu dem Zeitpunkt nichts gebracht als Intel das eingeführt hatte, weil kaum bis wenig Anwendungen davon profitiert hatten.

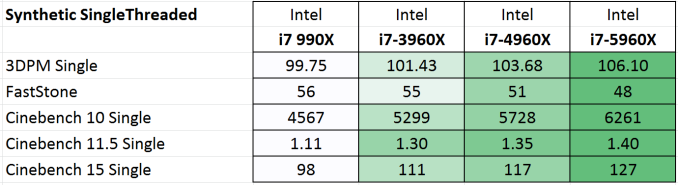

Darauf wollte ich hinaus. Ich wollte nur unter anderem beleuchten das eben damals die Leistungssteigerung zwar da war aber magerer war, als die Sprünge in den letzten 3 Jahren die durch Wettbewerb hervorgerufen wurden. Sieht man ja anhand von Anandtech Benchmarks, wie mager die effektiven Sprünge waren - Wenn man Taktraten und ggf. Stromaufnahme und irgendwelche Boost Mechanismen die kurzfristig die Leistung erhöhen nicht berücksichtigt. (E-Autos analog dazu gibt es auch schon seit mehreren Jahren, aber ohne passende Infrastruktur dazu ist es nicht effizient 50km zum Tanken zu fahren - als Beispiel)

Und sollte es in dem Markt wieder keinen vernünftigen Wettbewerb geben, wird die Innovation wieder stagnieren.

Alle großen Unternehmen orientieren sich an dem Schema

https://de.wikipedia.org/wiki/Produktlebenszyklus

und so lange da kein Druck vom Wettbewerb da ist, das die Produkte schneller "veralten" - weil ein anderer ein besseres Angebot machen kann, wird die Innovation immer gedrosselt. -siehe Telekom und Glasfaserausbau bis ins Haus.

Das heißt nicht das der Hersteller hinter den Kulissen nicht schon die Blueprints für die Produkte der Zukunft in der Schublade hat, sondern nur das die einfach nicht ausgespielt werden und der Kunde weniger fürs Geld bekommt als könnte.

Genau das hatte Intel in den Jahren nach Core2Duo bis Zen1 immer so gespielt. Ein Umstieg von einer Generation zu nächsten hatte sich effektiv weniger gelohnt, es sei denn man wollte die neuen Schnittstellen haben oder schnelleren Speicher -mehr Kerne hatte man im Konsumentenbereich eher nicht bekommen und eben die IPC Steigerung war eher magerer.