@

DDbom:

Mein "Gejammer", wie du es nennst, beschränkt(e) sich eigentlich auf die vorige

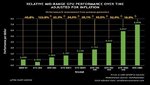

falsche Aussage von 50 % Leistungseigerungen zwischen fast jeder (Nvidia) Generation untereinander!

Aber schön und bezeichnend, das nur "der Teil" hängen geblieben ist!

Danach beschränkt sich mein Gejammer auf die Preispolitik seit dem Mining Boom, egal vom wem & das wir alle "abnicken" & kaufen.

Was dir wie erscheint ist mir eig egal. Es ging um die Kosten. Und es war mal sau teuer. Und denn wieder günstiger.

Da die 3090 eine Titan weitestgehend ersetzt laut Jensen, ist sogar die erstmal billiger geworden. Dir wird in dem Budget eine 3070 oder etwas von AMD geboten (500Euro) verstehe das Gejammer nicht.

Alles war mal "sau teuer". Willst du die ersten in Serie gefertigten Autos, Flugzeuge, oder demnächst "Tourismus im All" damit gleichsetzen? Schöne Grundlage für eine Diskussion!

Mein erster eigener PC war bei ca. 2000 DMark (333 MHz Intel schlag mich tot)... Na und, was heißt das jetzt in diesen Bezug?

Das dein Prospekt von Anno 1995 ein schlechtes Angebot hatte?

Oder das PCs zu dieser Zeit einfach noch selten im Privatsektor waren und eigentlich nicht primär für das Spielen gedacht waren?!

Ich bin mir sehr sicher, dass du das Prospekt bei jeder Diskussion zu Preisen auf den Tisch legst.

Hier habe aber ich,

den Preis für die geleakte Rohleistung in Verhältnis gesetzt! Darauf gehst du aber überhaupt nicht ein. Danke.

Mit einem Prospekt zu wedeln, geht wesentlich schneller & passt halt immer, anstatt in eine sachliche Diskussion zu gehen?

Achtung, die nachfolgenden Sätze können leichte Spuren von Sarkasmus / Ironie besitzen und sollten auch so verstanden werden...

Aber du hast Recht, für jeden wird wieder etwas geboten, egal in welchem Preisbereich!

Deswegen kam ich u.a. auf den VRAM der 3080 zu sprechen, aber auch das ist ja "OK", da ja für jeden Preisbereich etwas vorhanden ist... richtig! : )

Jeder der mag, kann sich ja vorerst die günstigste Titan aller Zeiten kaufen (deine Worte) = 3090 kaufen, wenn der VRAM von 10 GB in einem Jahr ausgehen sollte (was er bekanntermaßen jetzt schon tut bei 4K & vor allem großen Texturen).

Und um die early adopter wieder zu belohnen, wird 2021 eine 3080 Super mit ein wenig mehr VRAM nachgeschoben, natürlich auch mit einen sehr guten Preis / Leistungsverhältnis seit Maxwell / Pascal.

Das die erste und zweite Generation der wirklichen Titan auch mal wirklich Sinn ergab (Double Precision Performance), ist längst Geschichte! Seitdem werden höchstens Cuda Cores / RTX Tensor Cores als Kaufargument gerechtfertigt.

Und machen wir uns nichts vor, Nvidia hat noch die wirkliche Titan bereit, falls AMD wiedererwarten kontern könnte...Was sie nicht können werden.

Damit lass ich den ganzen Off Topic Quatsch, welcher immer Bezug auf die 3080 besaß.

Meine persönliche Meinung, meine sachliche Kritik

mit Logik & Menschenverstand / Quellen zu versehen, scheint nicht angebracht zu sein.