Das entfällt natürlich komplett bei SSDs

Das verhällt sich bei SSDs genauso.

Es gibt auch bei SSDs Latenzen, genauso wie sie es bei HDDs gibt. Gleiches gilt für die Datenrate.

Der Zusammenhang zwischen Latenz und Datenrate ist bei SSDs genauso wie bei HDDs.

Es können erst weitere Daten geschrieben werden, wenn der vorhergehende Schreibprozess abgeschlossen ist und das System nach der Latenz wieder bereit steht.

Der einzige Unterschied zwischen SSDs und HDDs ist, wo diese Latenz herkommt. Da ist bei der HDD die Kopfposition nur ein Teil, wenngleich der überwiegende. Ein weiteres Merkmal ist, dass SSDs das, theoretisch, auch intern parallel können. Das kommt aber auch den Controller und dessen Firmware an. Aber auch HDDs können das parallel, denn die haben ja auch mehrere Köpfe, wenngleich das nicht unabhängig ist, wie es bei SSDs der Fall ist.

Bei SSDs ist es primär erstmal die Zeit, die der Controller braucht sich zu sortieren und die Daten auf dem Flash abzulegen und dann ein rdy zurückzumelden.

Das Problem bei >SLC SSDs ist, dass in den Speicherzellen Organisationsprozesse stattfinden. Und die werden bei immer höherem Level eben zunehmend ein Problem.

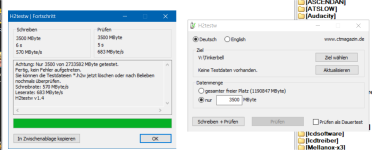

Daher ist SLC-Cache eine Kaschierung und gaukelt dem User eine Geschwindigkeit vor, die er eben nur unter ganz bestimmten Gesichtspunkten hat. Grob kann man die SSD als bei QLC nur zu 1/4 befüllen. Ab dann rödelt sich die SSD einen ab.

Die alten Hasen kennen das noch von den Defragmentierungsarien bei HDDs. Das war am Ende nichts anderes, als dass man der HDD geholfen hat die Daten wieder in die richtige "Reihenfolge" zu bringen. Mit dem Unterschied, dass bei der HDD "optional" war, die Reorga bei SSDs ist aber notwendig.

Kurzum, die Latenz der SSD steigt für eine Schreiboperation, genauso wie sie eben bei einer HDD auch der Fall ist.

Und darunter leidet dann irgendwann die Datenrate, da man immer mehr wartet als wirklich zu arbeiten, wenn man so will.

Und da kann ein RAID auch nicht mehr helfen. Wenn alle SSDs im RAID5 sich einen abkaspern mit dem hin- und herkopieren, dann muss man eben warten. Wovon du aber ausgehen kannst, dass deine IOPS größer ist, als wenn du eine einzelne SSD hast.

D.h. die Zahl der random I/Os pro Sekunde steigt nicht mit einem größeren RAID (mehr Disks), sondern sinkt. Schneller wird es nur wenn kontinuierlich Daten geschrieben/gelesen werden, also z.B. große Filmdateien.

Das ist Unsinn. Vornehmlich diente RAID dem Erhöhen der IOPS.

Sprich da, wo man mit einer HDD nicht mehr hingekommen ist, hat man, bei Kapaeffizienz, einfach solange mit HDDs draufgehauen, bis die IOPS wieder im Rahmen waren.

Das hat Grenzen und ist nicht vergleichbar, was SSDs können. Aber im RAID gilt/galt je mehr HDDs, desto mehr IOPS.

Was bei sowas hilft, wenn man SLC-Cache-Gelumpe einfach weglässt. Denn der initiale max. Speed bringt die später auch nichts. Lieber schreibe ich halbwegs konstant mit 1GB/s anstatt mit kurz 6GB/s und dann später mit 200MB/s.

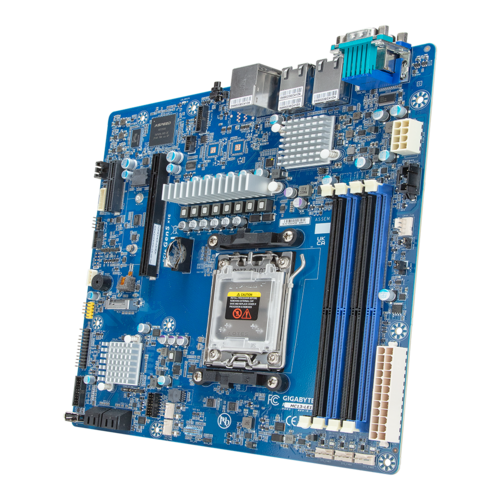

Auch sollte man nicht vergessen, dass es einen Unterschied zwischen Enterprise und Consumer gibt. So ne Enterprise SSDs ist eben auf eine ganz bestimme workload hin optimiert zusammen mit den internen Routinen und auch dem Interface (SAS vs. SATA)

Und ja, das war auch Realtek.

Und ja, das war auch Realtek.