Induktor

Enthusiast

- Mitglied seit

- 03.11.2019

- Beiträge

- 3.180

- Laptop

- Lenovo Yoga Pro 7 - Ryzen AI 9 365 - Radeon 880M - 32GB LPDDR5x-7500 - 14,5" OLED (2880*1800) 120Hz - Intel AX210

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen-7 9800X3D (+200/ -42)

- Mainboard

- MSI X870E Carbon Wifi (A3)

- Kühler

- Arctic LF III 280 & 2x Toughfan 14 Pro

- Speicher

- 32GB - 6200 MT/s (CL26-8-36-30 - tRFC 120ns)

- Grafikprozessor

- MSI RTX 4080 Gaming X Trio (Shroud Mod 3x T30 + 400w vBIOS)

- Display

- Alienware AW2725DF (OLED 360Hz)

- SSD

- Samsung 990 Pro & 980 Pro

- Gehäuse

- Open Benchtable V2 (vertikal)

- Netzteil

- Corsair AX850 (Titanium)

- Sonstiges

- Thermal Grizzly AM5 Frame

Bei mir war es genau umgekehrt. Hatte drei AMD GPUs (6900XT, 6900XT mit XTXH und 6950XT) und überwiegend positive Erfahrungen gemacht. Der Wattman ist zeitgemäß und lässt viele nützliche Einstellung zu. Da kann sich Nvidia sicherlich das ein oder andere mal abgucken.Mit Grafikkarten ist es ab und an getreu dem Motto: "Was der Bauer nicht kennt, frisst er nicht"...... Der kurze Ausflug hat mir das klar vor Augen geführt

Eigentlich hätte ich gerne wieder AMD als GPU genommen, aber es gab halt einige Dinge, die mir massiv auf die Nerven gingen, die man mit Nvidia eben nicht hat. Der übertriebene idle-Verbrauch im Multi-Monitor-Betrieb ist da ein Punkt beispielsweise. Gut, der ist mittlerweile besser (nach über einem halben Jahr), aber auch nicht bei jedem User. Auf diese "Fine Wine"/ Beta-Tester-Geschichte habe ich keine Lust, wenn ich über 1.000€+ für ne GPU zahle.

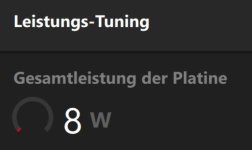

Effizienz ist der nächste Punkt:

Die Einstellung speziell nicht, aber unter 200w ist bei Nvidia keine Kunst. Spiele auf 4K mit'm 120fps Cap. Bin mit meiner 4080 inkl. UV in den meisten Games (die ich spiele) bei 165-195w. In der Vergangenheit war das eigentlich ein Punkt, den AMD gut konnte (Effizienz sein), aber an die Effizienz von Lovelace kommt Radeon 7000 einfach nicht dran.Bei 30 FPS fällt die GPU auf 188Watt auf 3840x1600... das hat Nvidia in der Form einfach nicht.

Kann ich jetzt nicht unbedingt bestätigen. Spiele nach wie vor auf meinen beiden Free Sync Premium Pro/ G-Sync kompatibel Monitoren und sehe da jetzt nicht wirklich einen nennenswerten Unterschied. Hab jetzt aber auch nicht großartig mit irgendwelchen Einstellungen diesbezüglich herumgespielt oder irgendwelche Ansprüche, die Competetive Gaming betreffen. War ehrlich gesagt immer zufrieden wie es war und mit Nvidia immer noch ist.Das Bild ist bei Shootern deutlich klarer in Bewegung weil Freesync Premium Pro einfach besser funktioniert als G Sync kompatibel.

Beide Hersteller haben ihre Vor- und Nachteile. Ich selbst bin Befürworter von FSR/ DLSS und FG und nutze es immer, wenn es verfügbar ist, weil es den Verbrauch deutlich verbessert. Während man bei AMD nur FSR nutzen kann, kann man mit ner Nvidia-GPU DLSS, FG und FSR nutzen.Ich vermisse gar nichts bei AMD, sogar eher bei Nvidia, bis vielleicht auf Frame Generation in Cyberpunk 2077, aber auch nur im Pathtracing, das wars.

auch komplett @Stock

auch komplett @Stock