Moin,

gefühlt habe ich mit dem neuen 23.7.2 wieder das Problem erhöhter Idle Leistungsaufnahme?! Wo die Karte vorher schön auf 7W im Idle runterging, bin ich nun wieder bei über 40W. Kann das jemand bestätigen?

@GodForsaken @tim_s007

Denkt euch nichts, mit gewissen Problemen kämpfe ich schon von Anfang an was bit, 2 Monitore oder gar 3 betrifft. Zudem gibt es immer wieder unerklärliche Treiberresets (auch ohne OC bzw Standardeinstellungen), abgesehen vom hohen Idleverbrauch, usw usw. Bin schon fast am Überlegen ob ich nicht einfach ein paar Euro versenke und Team Grün per 4090 unterstütze auch wenn ich solch übertriebene Preise nicht gut finde, aber mit RNDA3 habe ich teils mehr Probleme als mit RDNA2.

MPT zum Beispiel gibt es nicht mehr für RDNA3 und gerade bei OC geht ohne EVC bei einer 7900XTX oder 7900XT nicht viel. Die Karten sind von Grund auf alle Powerlimitiert.

Was neuere Treiber betrifft. Diese generieren oft weniger Leistung als Ältere, vor allem per Timespy merke ich das. Gut Timepy ist ein Benchmark und das könnte man ja noch vernachlässigen.

Bei RDNA2 war das anders. Da gab es, nach ebenfalls längeren Problemen, zumindest irgendwann regelrechte Leistungsschübe von Treiber zu Treiber, nicht nur in Benchmarks sondern auch in vielen Games.

Zum Thema Idleverbrauch. AMD bekommt das einfach nicht wirklich gebacken. Vor allem bei nur einem Monitor kann man sich ja noch glücklich schätzen, aber mit mehr als einem Monitor ist es ein Desaster was die da abliefern. Nervt mich schon wenn unsinnigerweise beim Daddeln im Netz oder auch bei einem lausigen Youtubevideo einfach sinnlos Energie verballert wird.

Das Dumme ist die Grafikkarte orientiert sich anscheinend daran wie viele Kabel in den Anschlüssen stecken egal ob der Monitor an oder aus ist. Ziehe ich zum Beispiel während dem Betrieb vom PC das Kabel vom Zweit-Monitor aus der Grafikkarte geht der Idleverbrauch auch auf momentan knapp 30 Watt runter bei 120 Hertz und 12 bit bei UHD. Das heißt es hilft nichts wenn ich den 2ten oder 3ten Monitor einfach nur abschalte, denn dann bleibt der Idle Verbrauch trotzdem bei knapp 80 Watt nur für die Grafikkarte. Mein Strommmessgerät an der Steckdose bestätigt das bzw es ist kein Auslesefehler der Software.

Erst wenn ich wie erwähnt das Monitorkabel aus der Graka ziehe geht der Verbrauch deutlich runter. Es ist auch egal ob ich 2 oder 3 Monitore dran habe, der Verbrauch im Idle bleibt nahezu identisch, sprich 82 Watt bei 2 Monitoren und unglaubliche 83 Watt bei 3 Monitoren.

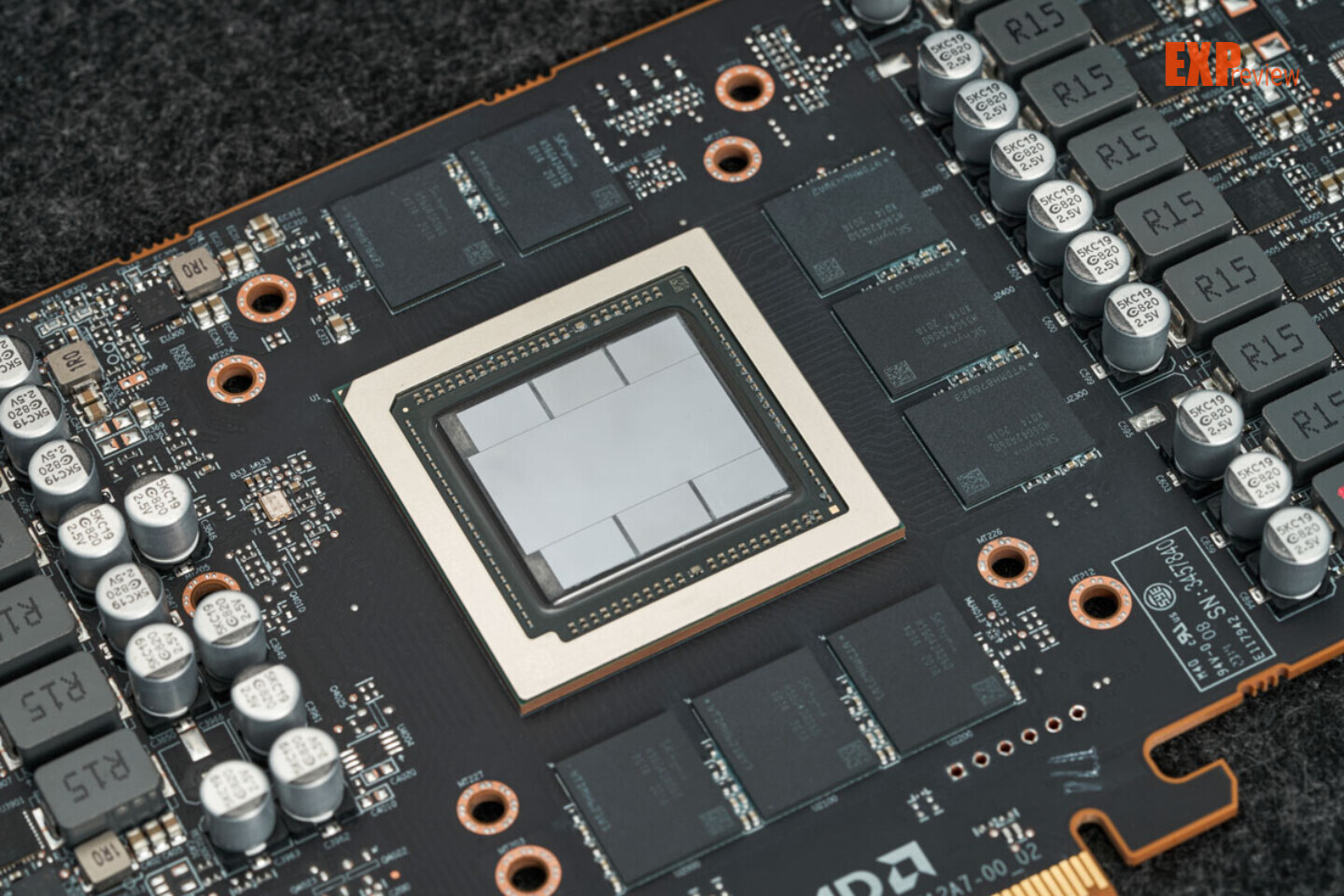

Warum so Manches einfach nicht funktioniert sind Vermutungen. DevPandi aus dem CB Forum hat einen wirklich interessanten Artikel geschrieben. Einfach mal durchlesen und vor allem in der Rubrik P-State Problem oder auch Hardwarebug könnte darauf hindeuten das AMD einfach immer noch ein riesiges Problem hat. RDNA3 könnte vermutlich deutlich mehr im positiven Sinne, aber man hat mit dieser Generation anscheinend ein unlösbares Problem, vor allem wie man die Karte anspricht und zusätzlich der hohe Verbrauch, egal ob Idle oder Last um es kurz zu fassen.

DevPandi Artikel CB

)

)