tim_s007

Enthusiast

- Mitglied seit

- 24.06.2007

- Beiträge

- 970

- Ort

- An der Küste

- Desktop System

- PC!

- Laptop

- Schläppi

- Details zu meinem Desktop

- Prozessor

- i9-13900ks@+100Mhz@H²O, 12900k@5,2 allcore im ITX

- Mainboard

- MSI Z790 Godlike, Gigabyte Xtreme Z690, MSI Z690i

- Kühler

- XPX Core 1 for LGA 1700, NexXxoS UT60 Full Copper 1080mm Nova, Leakshield, aquaero6, D5 usw.

- Speicher

- DOMINATOR TITANIUM RGB 48 GB DDR5 8200 / XPG Lancer DDR5 7200

- Grafikprozessor

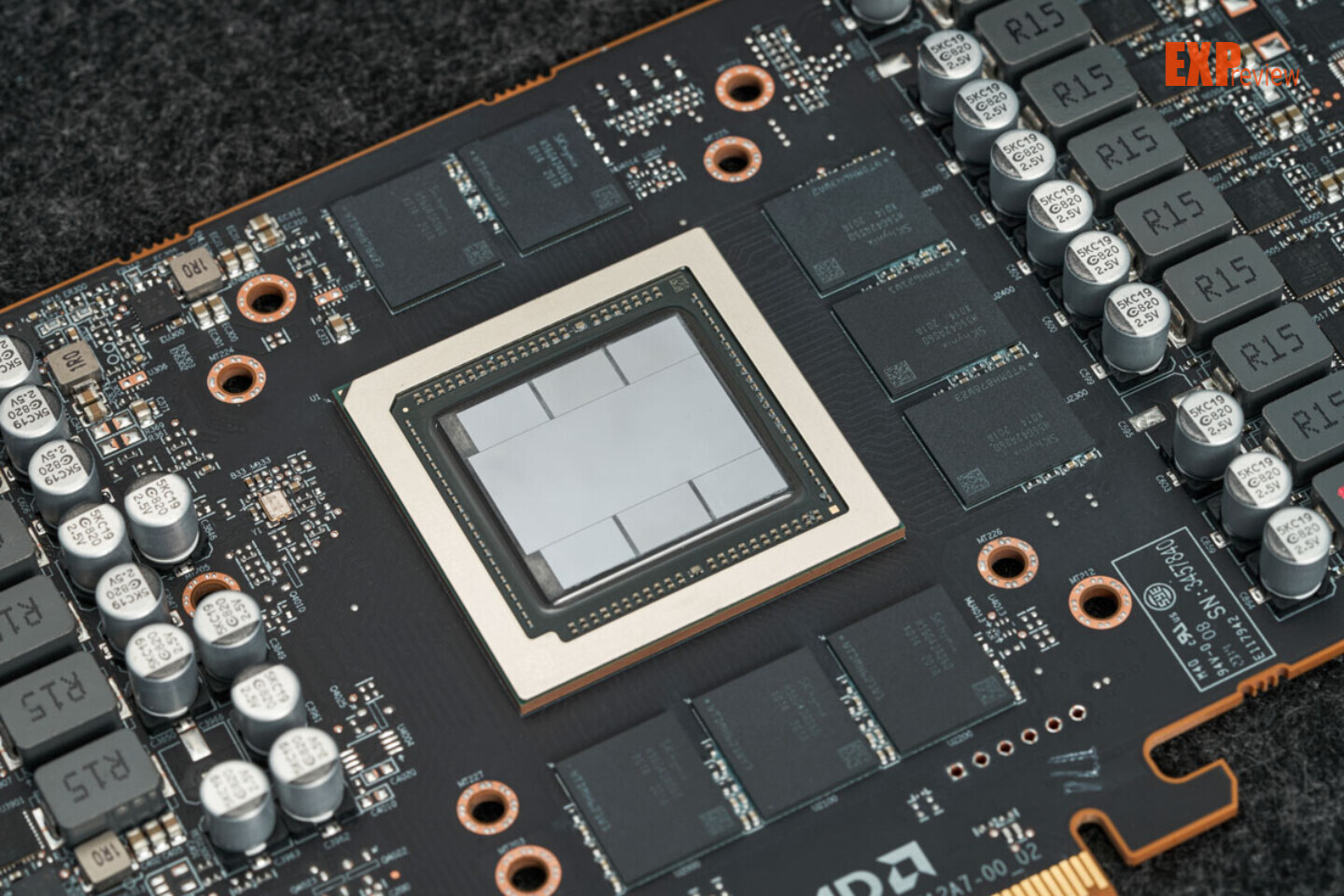

- 7900XTX Sapphire Nitro+@alphacool Core1 und evga RTX 3090 FTW3 Ultra im ITX, RX9070xt Prime

- Display

- Asus PG32UCDM, Dell G3223Q & Dell P2223HC

- SSD

- 2x SN 850 1TB, 1x Crucial P500 plus 2TB und 4 x 2TB Samsung Enterprise SSDs im raspberry5 Homeserv.

- HDD

- No, nur einige NVME SSDs über USB

- Opt. Laufwerk

- BluRay USB

- Soundkarte

- Soundblaster X4 over KVM

- Gehäuse

- Jonsplus i400, Lian Li Q58

- Netzteil

- Corsair HX850i Platinum

- Keyboard

- G915

- Mouse

- G903

- Betriebssystem

- Windoof 11

- Webbrowser

- Firefox, Edge, Chrome, ... was soll die sinnlose Frage

- Sonstiges

- 4bay Raspberry PI 5 NAS mit OMV7, 3D Drucker Ultimaker 3S, DP 1.4 DUAL 8K 4-fach KVM

- Internet

- ▼250 MBit ▲40 MBit

Ich habe aus der Not heraus den 2ten Monitor an die interne Grafik gehangen und betreibe nur den "Großen" mit 4k@120Hz an der 7900XTX. Ich hab endlich Werte um die 10W. Allerdings NUR, wenn ich die Farbtiefe auf 10bit setze. Farbtiefe auf 8Bit erzeugt sofort wieder eine Last, um die 50W (zum Glück nicht anders herum). Der Monitor ist ein Dell G3223Q. Andere Wiederholraten werden teilweise auch mal mit hoher Last quittiert. HDR bislang nicht aktiviert. So ganz rund läuft das immer noch nicht.

Mal schnell probiert:

Auflösung immer 4k mit Freesync Pro aktiv

144Hz rund 10W

120Hz rund 10W

100Hz rund 90W <--- das ist ein schlechter Scherz

Mal schnell probiert:

Auflösung immer 4k mit Freesync Pro aktiv

144Hz rund 10W

120Hz rund 10W

100Hz rund 90W <--- das ist ein schlechter Scherz

Zuletzt bearbeitet:

)

)