Ich denke die ganze "Meckerwelle" wg. der Preise ist hauptsächlich nVidias "Founders Edition" und dessen höheren UVP geschuldet. So etwas gab es eigentlich noch nie daß man für Referenz Design (und nichts ansderes ist die FE) deutlich mehr bezahlt als für die Custom Lösungen. Hätte man diese Referenz Karte gleich bei 599 USD angesiedelt wäre das zwar noch immer teuer, aber der Aufschrei wäre vielleicht nicht so groß.

Der Beitrag von Heise ist natürlich (vor allem im Titel) übertrieben dargestellt, denn man kann ja zu kleineren/preiswerteren Modellen greifen und damit immer noch glücklich sein.

Was mir persönlich (auch schon bei der 900er Serie von nV, aber auch bei AMDs 300er Serie) etwas aufgestoßen ist sind die durchgehend hohen Preise, nicht nur bei High End, sondern eben auch in der Performance Klasse, teils bis runter ins Mid Range. Die schnellsten Karten bzw. High End Karten waren schon immer teuer und meist unverhältnismäßig viel teurer als oft schon das Modell direkt darunter. Das ist in Ordnung und darüber meckere ich auch nicht. Wenn die schnellsten Karten jedoch so teuer werden daß die Modelle darunter ebenfalls preislich angehoben werden (jeweils im Vergleich zu den Generationen davor) ist das natürlich nicht so schön. Und kommt mir nicht mit "... aber die Karte leistet ja auch viel mehr als die davor ...". Na klar ist das so, wenn nicht müsste man ja für mehr Leistung jedes Mal mehr Geld hinlegen und wir hätten irgendwann Karten die sich kaum noch einer leisten kann bzw. will.

Was mir bei eben der 900er Serie aufgefallen ist ist daß die Preise kaum gefallen sind über die Lebensdauer der Karten. Erst jetzt wo die Nachfolgekarten schön langsam in die Läden kommen bzw. sind fallen die Preise. Üblicherweise war es so daß die Release Preise relativ hoch waren, die Karten jedoch mit der Zeit günstiger wurden. Somit konnte man, wenn einem der Preis einer Karte zu Release zu hoch war, etwas warten und dann die Karte etwas günstiger erwerben. Bei der GTX 980 bzw. 970 war das kaum so.

AMD hatte zum Ende der 290er Karten deutlich niedrigere Preise als zum Release, hat dann jedoch die selben Karten mit mehr Takt und mehr RAM zu wieder deutlich höheren Preisen neu released. Auch nicht schön.

Zu der Geschichte kommt halt noch der schlechte USD<->EUR Kurs sowie der Trend (bzw. Hype) zu immer höheren Auflösungen, 3D und nun auch (wieder einmal) VR. Wie viele schon festgestellt haben fordert dies teils enorm viel Leistung. Ich persönlich halte es aktuell nicht unbedingt notwendig UHD auf Monitoren < ~ 27" zu haben. Ich bin bis jetzt auch noch mit 1920x1200 unterwegs, obwohl ich schon auf 1440p schiele, jedoch mit dem Wissen daß dafür auch eine neue GPU her muß.

Die Grafiken die hier erstellt wurden sind zwar nett anzusehen, allerdings müsste man wohl unzählige verschiedene anfertigen um vielleicht irgendetwas daraus abzulesen. Die Release Preise der jeweils schnellsten Karte ist eine nette Sache, die der Modelle darunter wäre auch interessant und vielleicht eben auch der Verlauf der Preise dieser. Das ist jedoch sehr schwer machbar. Die FPS pro Geldeinheit ist zwar auch eine gute Idee und auch die Auflösungsanpassung der Jahre ist in Ordnung. Aber vergleichen kann man das nicht da es hier natürlich extrem auf die Spiele ankommt die in die Werte einfließen. Ich mein es gibt ja High FPS Spiele wie Quake 3, CS/Source/Go uvm. und dann gibt es Low FPS Spiele wie Crysis, Metro, Stalker etc. Die Rohleistung der GPUs macht natürlich auch nicht viel Sinn da die nicht immer direkt die Real World Leistung der Karte widerspiegelt usw.

Generell vermute ich bei den GPUs eine ähnliche Problematik wie bei den CPUs schon in den letzten Jahren zu beobachten ist. Es wird immer schwerer und teurer diese in kleineren Fertigungen herzustellen und diese im selben Ausmaß wie früher schneller zu machen. Bei den CPUs kommt ja die Kernthematik im Otto-Normal Endkundenmarkt dazu was bei GPUs glücklicherweise nicht der Fall ist da hier deutlich besser parallelisiert werden kann. Gerade die Fertigungssprünge dauern hier auch länger, deswegen vermute ich auch daß nV die Strategie von früher, wo meist das neue High End Produkt bzw. dickste Karte einer Serie als erstes released wurde und max. davor eine MidRange Karte der alten Generation als "Test" in der kleineren Fertigung hergestellt wurde umgestellt hat. Eben auf "wir bringen erst mal eine schnelle Performance Karte, die jedoch trotzdem leicht schneller als die alte High End ist, und danach dann wieder die echte High End Karte". Intel sind ja auch von Tick-Tock auf Process-Architecture-Optimization umgestiegen.

Bei AMD wird es ähnlich sein, wobei hier in den letzten Jahren deutlich mehr alte Modelle neu verwurstet wurden.

Aktuell heißt es für mich zumindest abwarten ... mal sehen wie sich die Preise der GTX 1080 entwickeln, vor allem wenn die 1070 und dann auch Polaris am Markt ist. 789 EUR bzw. 499 EUR für die Referenz 1080 bzw. 1070 sind in meinen Augen zu hoch angesetzt. Custom Modelle mit ~ 650 EUR bzw. (hoffentlich so) ~ 400 EUR sind schon besser, allerdings immer noch etwas hoch für die Modelle (Klasse) die sie sind.

AMD rollt hier das Feld von unten auf, die 199 USD werden bei uns so um die ~ 230-250 EUR ergeben und vielleicht ~ 280-300 EUR für die 8GB Modelle. Bleibt abzuwarten wie die Leistung der Karten dann tatsächlich aussieht und wie sich (bzw. ob sich) die Preise dann auch ändern (eben auch bei nV).

Ich hoffe endlich wieder etwas einen Preiskampf zu sehen, für die größeren nV Karten müssen wir jedoch wohl auf Vega warten und da bin ich froh daß diese angeblich früher kommen soll als erwartet.

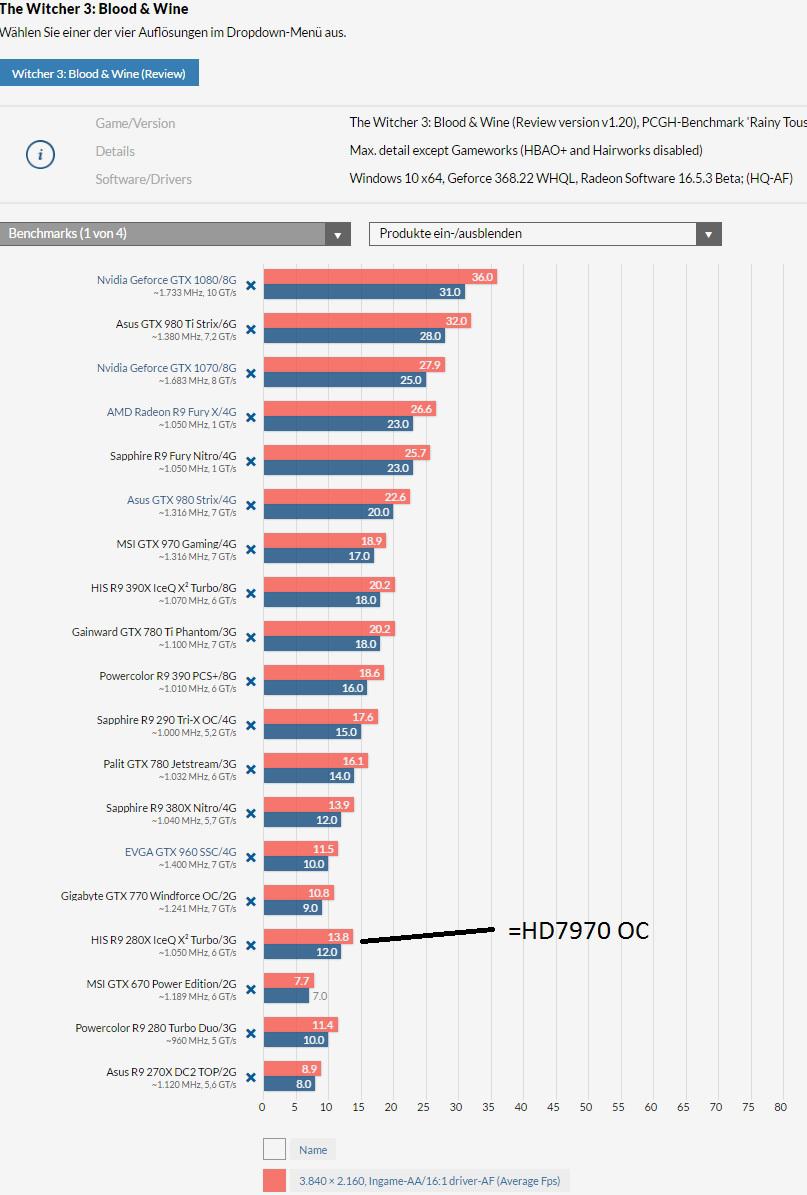

Ich kaufe mir auch keinen Pentium G und erwarte The Witcher 3 maxen zu können.

Ich kaufe mir auch keinen Pentium G und erwarte The Witcher 3 maxen zu können.

ich habe die genauen Daten der Grakas nicht im Kopf, aber bei den meisten zockern steht die Graka sowieso auf Höchstleistung nicht auf Energiesparen und da vermutlich wenig Leute die FPS einschränken werden die schon gut Strom lutschen. Obs dann statt meinen angegebenen 50 "nur" 35/40€ im Jahr mehr sind auch egal.

ich habe die genauen Daten der Grakas nicht im Kopf, aber bei den meisten zockern steht die Graka sowieso auf Höchstleistung nicht auf Energiesparen und da vermutlich wenig Leute die FPS einschränken werden die schon gut Strom lutschen. Obs dann statt meinen angegebenen 50 "nur" 35/40€ im Jahr mehr sind auch egal. viele Stellen sich das alles immer so einfach vor.)

viele Stellen sich das alles immer so einfach vor.)