Werbung

Für die Ausgabe und Darstellung auf dem Display wird ab diesem Jahr das Thema High Dynamic Range von großer Bedeutung sein. AMD kündigte bereits im vergangenen Jahr an, dass die zukünftigen GPUs HDR unterstützen werden. HDR beschreibt eine höhere Darstellung von Helligkeitsunterschieden und einem größeren Dynamikumfang im Vergleich zu Standard Dynamic Range (SDR). HDMI 2.0a beispielsweise unterstützt grundsätzlich eine Übertragung in HDR, Amazon Prime Instant Video bietet einige Inhalte in den USA inzwischen damit an, die neuen 4K-Blu-rays sollen ebenfalls den höheren Dynamikumfang unterstützen. Netflix streamt seit Anfang 2016 ebenfalls erste Inhalte mit HDR-Unterstützung.

Um die Unterschiede zwischen HDR und SDR zu kennen, muss man folgendes wissen: Ähnlich wie bei den Bildwiederholungsraten von Monitor- und Fernseh-Panels schleppen die Hersteller auch bei den Übertragungstechniken noch Altlasten mit sich herum, die aus der Zeit der Röhrenmonitore stammen. Dazu gehört das Fehlen von Übertragungsstandards, die zusätzliche Informationen, wie eben zum Beispiel HDR, an die Ausgabegeräte liefern können. Also auch wenn Kino- und Fernsehproduktionen mit HDR-Informationen aufgenommen werden, werden diese Informationen bei der Übertragung wieder entfernt und heruntergerechnet. Dies betrifft den Farbraum ebenso wie Kontrast und Leuchtdichte, die aktuell bei maximal etwa 100 cd/m² liegt. Dies sorgt dafür, dass ein Schwarz nicht wirklich schwarz ist und bei zu hellen Darstellungen Informationen teilweise verloren gehen.

Nun gibt es aber mehrere Ebenen innerhalb der Erstellung von Video-Inhalten, die aufeinander abgestimmt werden müssen. Dazu gehören das Aufnahmeverfahren, die Bildbearbeitung, die Distribution in Form von Medien und eben die Darstellung auf dem Display selbst. Die Hersteller von Fernsehern und Monitoren versuchen dies mit eigenen Dynamic-Profilen und Anpassungen etwas abzufangen, doch verlorengegangene Informationen lassen sich im Nachhinein nicht mehr hinzufügen und so können diese Details allenfalls interpoliert werden. Auch technisch stehen die Hersteller dabei noch vor Herausforderungen, denn die Vorgaben von HDR lassen sich derzeit noch nicht direkt umsetzen. So bieten LC-Panels die notwendige Helligkeit, rechen beim Schwarzwert aber nicht an die Darstellungsqualität heran, wie sie OLED-Panels bieten. Auch die Hintergrundbeleuchtung muss weiter verbessert werden, um eine dynamischere Leuchtdichte zu erreichen. Einzelne Bereiche des Panels müssen deutlich granularer angesteuert werden, was die Hintergrundbeleuchtung deutlich komplexer und schwieriger macht als dies aktuell der Fall ist.

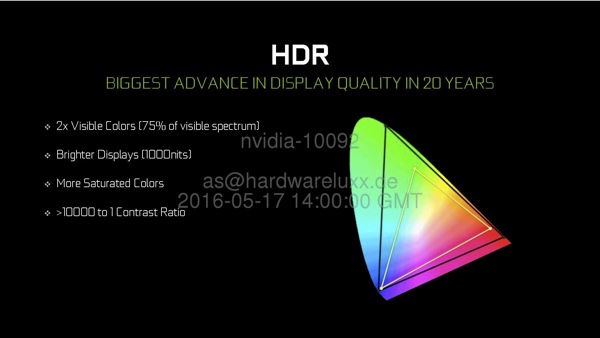

Für Darstellungen mit einer solch hohen Dynamic gibt es wie im Audio-Bereich bereits einen Standard namens Dolby Vision. Dieser sieht beispielsweise eine maximale Leuchtdichte von bis zu 4.000 cd/m² vor, was ein Vielfaches der aktuell möglichen Leuchtdichte entspricht. HDR in der ersten Fassung beschränkt sich allerdings zunächst einmal auf 1.000 cd/m² sowie ein Kontrastverhältnis von 10.000:1 bei einer Farbabdeckung von 75 Prozent des sichtbaren Lichtspektrums. Bis wir solche Darstellungen auch im heimischen Wohnzimmer bewundern werden können, werden noch Jahre vergehen.

Auf Seiten der Softwarecodecs ist man schon lange vorbereitet. So bietet HEVC derzeit als einziger "Consumer"-Codec die Möglichkeit, HDR-kodierte Inhalte wiederzugeben. Für solche Übertragungen wie sie Dolby Vision vorsieht, werden ebenfalls bestehende Codecs verwendet, die dann aber um zusätzliche Daten erweitert werden. Nur Dolby-Vision-Geräte können damit überhaupt umgehen und auch die Datenrate steigt um bis zu ein Viertel an, was zusätzlich Probleme bereiten kann.

Nicht nur größere Helligkeitsunterschiede können via HDR übertragen und ausgegeben werden, auch der Dynamikumfang bei den Farben ist mit HDR größer. Der sRGB- und Adobe-RGB-Farbraum dürfte den meisten etwas sagen. Darüber hinaus definiert sind Rec. 2020 und Digital Cinema (DCI) HDR-10 UHD TV mit einem deutlich erweiterten Farbraum, der in weiten Bereichen den Farbraum des menschlichen Auges abdeckt.

Wie auch bei den Filmen ist HDR in Spielen keine neue Erfindung. Bei Spielen wurde mit HDR versucht, einen größeren Dynamikbereich zu simulieren, denn intern konnte zwar damit gerechnet werden, ausgegeben werden konnte die Darstellung aber nur auf dem klassischen Wege, denn weder die Ausgabeseite der Grafikkarten, noch die Übertragung und schon gar nicht die Displays könnten die mit HDR-gefüllten Informationen ausgeben. Damals noch wurde eine übersättigte Darstellung von Lichteffekten als HDR-Darstellung verstanden, die natürlich keineswegs einer echten HDR-Darstellung entsprechen konnte. Auf dem Editors Day präsentierte NVIDIA zusammen mit den Entwicklern eine Version von Rise of the Tomb Raider mit HDR-Unterstützung. An die Darstellung wird man sich aber noch etwas gewöhnen müssen, denn gerade helle Bereiche wirken meist doch noch sehr übertrieben hell. Aber vielleicht hat sich das Auge auch nur an die Display-Darstellung der vergangenen Jahre gewöhnt und erkennt ein in dieser Hinsicht realistischeres Bild schon gar nicht mehr.

NVIDIA integriert in der Pascal-Architektur einen De- und Encoder mit der Möglichkeit HDCP in 10 Bit zu verschlüsseln. Damit wird ein Decoding in 4K@60 10/12 Bit HEVC möglich. Das Encoding beschränkt sich auf 4K@60 10 Bit HEVC (beispielsweise für ein einfaches Recording oder ein Streaming des Videosignales).

Im Zuge der neue Pascal-Architektur stellt NVIDIA auch neue Standards für die Display-Ausgänge auf der GeForce GTX 1080 und GTX 1070 zur Verfügung. So verfügen die beiden Karten über HDMI 2.0b und DisplayPort 1.3/1.4. Während bei DisplayPort 1.3 aber von einem bereits zertifizierten Standard die Rede ist, beschreibt NVIDIA DisplayPort 1.4 nur als "ready", da die VESA hier die finalen Spezifikationen noch nicht festgelegt hat. Man rechnet aber fest damit, alle Belange des Standards einhalten zu können. Dies beschränkt sich natürlich nur auf die Pflichtkomponenten von DisplayPort. Weiterhin nicht unterstützt werden optionale Komponenten wie das Adaptive Sync.

Mit den ersten Gaming-Monitoren mit HDR-Unterstützung rechnet NVIDIA ab Anfang 2017. Es wird also noch einige Zeit dauern, bis Spieler in den Genuß von HDR kommen. Wer sein Heimkino mit einem HDR-fähigen Fernseher ausstatten möchte, muss ebenfalls noch tief in die Tasche greifen müssen. Um ein Streaming vom mit einer Pascal-GPU bestückten PC an den Fernseher im Wohnzimmer zu ermöglichen, will NVIDIA das GameStream-Feature um GameStream HDR erweitern. Dann könnte zur Übertragung des Videos die Shield mit Android TV und eine Übertragung in HEVC 10 Bit verwendet werden. NVIDIA plant diese Funktion derzeit ab Sommer 2016 anzubieten.

Bei AMD sehen die aktuellen Empfehlungen für HDR wie folgt aus:

| Auflösung: | 1080p bei 120 Hz 10bpc | 1440p bei 60 Hz | 2160p bei 30 Hz | 2160p bei 60 Hz 10bpc |

|---|---|---|---|---|

| GPU-Serie: | Radeon R9 300 Serie | Radeon R9 300 Serie | Radeon R9 300 Serie | Radeon R9 300 Serie |

| Display-Ausgänge: | HDMI 1.4b DisplayPort 1.2 | HDMI 1.4b DisplayPort 1.2 | HDMI 1.4b DisplayPort 1.2 | HDMI 1.4b DisplayPort 1.2 |

| Inhalte: | Spiele | Spiele Fotos | Spiele Fotos | Spiele Fotos Filme |

Wer im Besitz einer NVIDIA-Grafikkarte mit Maxwell-GPU ist, den interessiert sicherlich welche Änderungen sich nun mit der Pascal-Architektur ergeben. NVIDIA stellt daher eine Tabelle zur Verfügung, welche die GeForce GTX 980 mit der GTX 1080 vergleicht.

| Grafikkarte | GeForce GTX 980 | GeForce GTX 1080 |

|---|---|---|

| H.264 Encode | Ja | Ja (2x 4K@60 Hz) |

| HEVC Encode | Ja | Ja (2x 4K@60 Hz) |

| 10 Bit HEVC Encode | Nein | Ja |

| H.264 Decode | Ja | Ja (4K@120 Hz mit bis zu 240 Mbps) |

| HEVC Decode | Nein | Ja (4K@120 Hz / 8K@30 Hz mit bis zu 320 Mbps |

| VP9 Decode | Nein | Ja (4K@120 Hz mit bis zu 320 Mbps) |

| MPEG2 Decode | Ja | Ja |

| 10 Bit HEVC Decode | Nein | Ja |

| 12 Bit HEVC Decode | Nein | Ja |