Werbung

Neben immer schnelleren GPU-Architekturen und dazugehörigen Frontends, ist die Speicherbandbreite einer der limitierenden Faktoren der derzeitigen GPU-Designs. High Bandwidth Memory sollte diesen Knoten lösen und tat dies teilweise auch, allerdings hinken Verfügbarkeit, Kosten und auch die technische Umsetzung den vor Jahren gesteckten Zielen weit hinterher. Die Radeon R9 Fury X von AMD war die erste Grafikkarte, die auf den HBM setzte. Doch schon damals waren Kapazität, Preis und Verfügbarkeit nicht auf dem gewünschten Niveau.

Daran hat sich in den vergangenen Jahren wenig geändert. AMD versuchte mit der Radeon RX Vega 64 und Vega 56 einen weiten Anlaufen die Speichertechnik in den Massenmarkt zu überführen, aber auch hier spielen die Kosten für den Speicher und die Implementierung von GPU und Speicher auf einem Interposer eine Rolle beim nur mäßigen Erfolg dieser GPU-Generation von AMD. NVIDIA hingegen schien die Situation etwas besser abschätzen zu können und entwickelte für die GeForce GTX 1080 Ti in Zusammenarbeit mit Micron den im Vergleich zu GDDR5 etwas schnelleren GDDR5X-Speicher. Auf HBM wollte man im Endkunden-Segment nicht zurückgreifen und beschränkte sich weiterhin auf den Einsatz für die Tesla-GPU-Beschleuniger sowie die teuren Workstation-Modelle aus der Quadro-Serie.

In einigen wenigen Bereichen erreicht HBM2 die vor Jahren geplanten Taktraten von 1.000 MHz – auf Grafikkarten ist dies bisher nicht der Fall und so sehen wir Speicherbandbreiten von bis zu 900 GB/s, aber noch nicht die versprochenen 1 TB/s. Dies gilt auch nur, wenn ein mit 4.096 Bit extrem breites und damit aufwendiges Speicherinterface zum Einsatz kommt. Bei den Consumer-Karten der Vega-Architektur von AMD kommt aber auch nur ein 2.048 Bit breites Speicherinterface zum Einsatz und somit ist bisher bei 484 GB/s das Ende der Fahnenstange für AMD erreicht.

Mit dem Einsatz von GDDR6 dringt NVIDIA nun hinsichtlich der Speicherbandbreite in Größenordnungen vor, die wir bisher nur von mit HBM bestückten Karten kennen. Samsung ist vorerst der exklusive Partner für NVIDIA in diesem Bereich und liefert GDDR6-Speicher mit einer Bandbreite von 14 GBit/s pro I/O Pin aus. Am 352 Bit breiten Speicherinterface der GeForce RTX 2080 Ti bedeutet dies eine Speicherbandbreite von 616 GB/s, bei der GeForce RTX 2080 mit einem 256 Bit breiten Speicherinterface sind es 448 GB/s.

Für eine bessere Übersicht haben wir die aktuell erreichten Speicherbandbreiten noch einmal in einer Tabelle gegenübergestellt.

| GDDR6 | GDDR5X | GDDR5 | HBM2 | |

| Bandbreite pro I/O | 14 GBit/s | 11 GBit/s | 4 GBit/s | 1,7 GBit/s |

| Speicherkapazität pro Chip | 1 GB | 1 GB | 512 MB | 4 GB |

| Bandbreite pro Stack/Chip | 56 GB/s | 44 GB/s | 28 GB/s | 217,6 GB/s |

| Spannung | 1,35 V | 1,35 V | 1,5 V | 1,2 V |

| Speicherinterface | 352 Bit | 352 Bit | 384 Bit | 4.096 Bit |

| Speicherbandbreite | 616 GB/s | 484 GB/s | 336,6 GB/s | 900 GB/s |

Um die einzelnen Merkmale der Speichertechnik besser herauszustellen zu können, haben wir in der Tabelle die praktische Umsetzung für den Einsatz von GDDR6, GDDR5X, GDDR5 und HBM2 in einigen Bereichen für den Einsatz zusammen mit GPUs übernommen. Sehr deutlich zu erkennen ist, dass HBM2 sicherlich Vorteile bei der Speicherbandbreite besitzt, dafür aber auf ein extrem breites und damit teures Speicherinterface angewiesen ist. Auf der anderen Seite kann GDDR6 sich bei der Bandbreite in Richtung von HBM2 bewegen, ohne derart teuer in der Fertigung und Implementierung zu sein.

Der aktuelle Einsatz von GDDR6-Speicher stellt nur den Einstieg dar. Die Hersteller wie Micron, SK Hynix und auch Samsung planen Chips mit größeren Kapazitäten und höheren Bandbreiten. Bis zu 20 GBit/s sind pro I/O-Pin zukünftig angedacht. Damit würde die Speicherbandbreite bei einem 352 Bit breiten Speicherinterface auf fast 900 GB/s ansteigen.

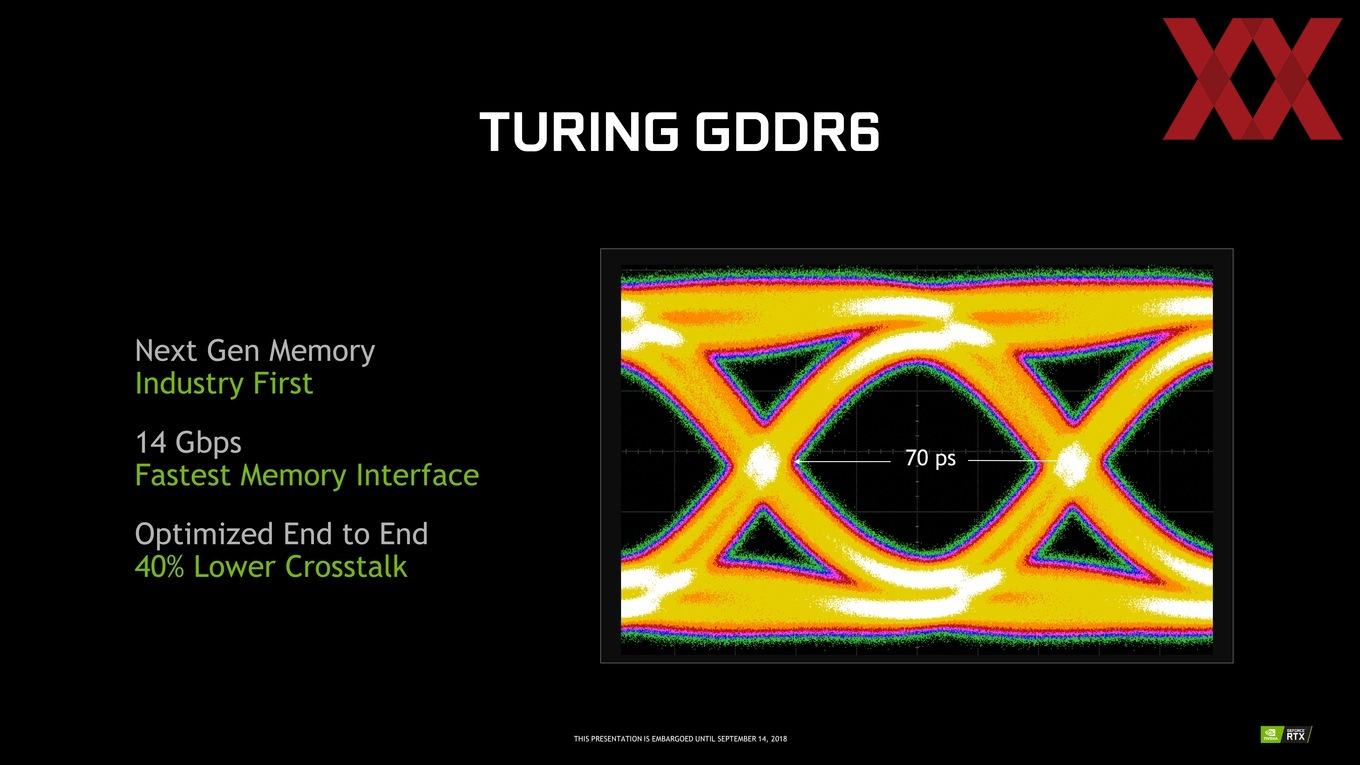

Eine der Herausforderungen eines solch schnellen Speichers ist die Signalintegrität bei der Übertragung Aufgrund des hohen Taktes. Es kommt zu einem Übersprechen des Signals und dies macht die Erkennung umso schwieriger. Obiges Bild zeigt ein solches Signal. Die Signalerkennung findet über ein High- und Low-Signal statt. Bei einem Takt von 1.750 MHz wechselt das Signal in 70 ps. Das Auge in der Mitte sollte für eine gute Erkennung möglichst klar und deutlich sein. Ist es das nicht, kommt es zu fehlerhaften Übertragungen.

Zu den Optimierungen für GDDR6 gehört unter anderem, dass man Signale verwendet, die sich überlagern und derart ausgleichen, dass ein klareres Signal dabei herauskommt. Damit ist es NVIDIA und Samsung möglich, den Takt des Speichers auf effektiv 1.750 MHz zu erhöhen.

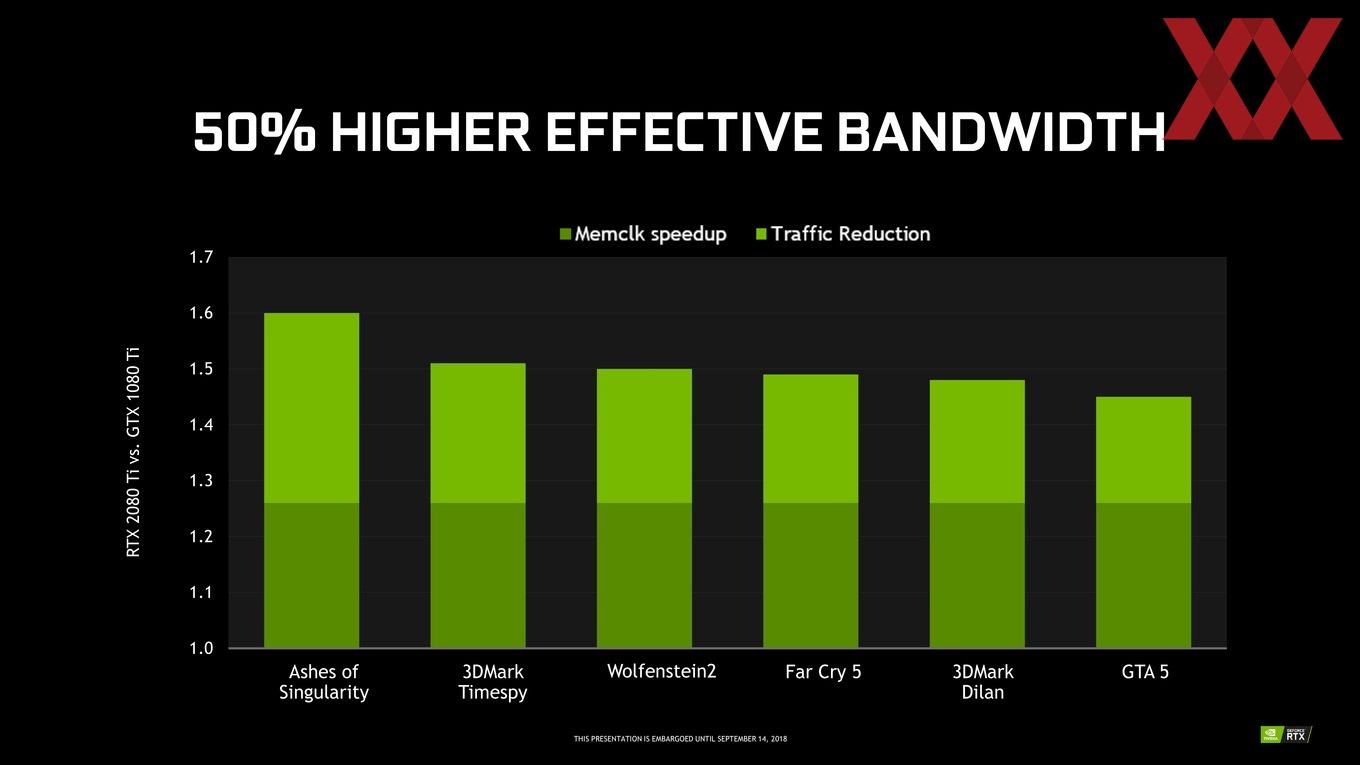

Die Speicherkomprimierung wirkt unterstützend

Ebenfalls eine Rolle spielen Verfahren für das Komprimieren von Daten im Grafikspeicher. Eine Delta-Farbkompression hat sich inzwischen bei GPUs von AMD und NVIDIA seit einigen Generationen durchgesetzt. Bei NVIDIA handelt es sich um die 5. Generation eines solchen Kompressionsverfahrens. AMD verwendet diese bereits mit der Tonga-GPU der Radeon R9 295. Wichtig dabei ist, dass es sich um ein verlustloses Kompressionsverfahren handelt. Es gehen also keiner Daten verloren und Entwickler können sich auf das Verfahren verlassen, ohne speziell darauf angepasst zu entwickeln.

NVIDIA verwendet für die Speicherkomprimierung eine sogenannte Delta Color Compression. Dabei wird nur der Basispixelwert gespeichert und für die umliegenden Pixel in einer 8x8-Matrix nur noch der Unterschied (das Delta) abgelegt. Da das Delta ein deutlich kleinerer Wert ist, kann dieser schneller gespeichert werden und es wird auch weniger Platz im Speicher benötigt. Es müssen also weniger Daten in den VRAM geschrieben und daraus gelesen werden. Komprimiert werden kann aber auch der einzelne Farbwert, sodass auch hier Speicherplatz oder besser Speicherbandbreite eingespart werden kann. Ein Beispiel für die Kompression ist ein vollständiges Schwarz und Weiß, deren Wert üblicherweise als {1.0, 0.0, 0.0, 0.0} oder {0.0, 1.0, 1.0, 1.0} im Speicher abgelegt wird. In einem einfachen Verfahren reichen aber auch die Werte 0.0 oder 1.0 aus, um dies eindeutig zu beschreiben.

NVIDIA hat die Verfahren zur Detektion der komprimierbaren Bildinhalte verbessert. Das bereits bekannte 2:1 Verhältnis kann also schneller angewendet werden und ist zudem auf einen größeren Datenbestand anwendbar. Neu hinzugekommen sind die Kompressionen um den Faktor 4:1 und 8:1.

So wird es möglich, zur Steigerung der Speicherbandbreite durch den schnelleren Speicher auch noch die Menge der Daten zu verringern, die übertragen werden müssen, was die Effektivität des Speicherinterface zusätzlich erhöht.