Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

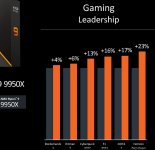

16 % IPC-Plus: AMD stellt die Ryzen-9000-Prozessoren mit Zen-5-Kernen vor

- Ersteller HWL News Bot

- Erstellt am

- Mitglied seit

- 15.01.2007

- Beiträge

- 19.449

- Ort

- Oberbayern

- Laptop

- Lenovo Thinkbook 15 G2 (Intel Core i5-1135G7, 16 GB RAM, 512 GB NVMe SSD, Intel Iris Xe)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 9800X3D

- Mainboard

- ASUS ROG Strix B650E-E Gaming WiFi

- Kühler

- be quiet! Dark Rock 4

- Speicher

- 2x 32 GB Kingston Fury Beast DDR5-6000 (1:1, CL30-36-36-80-1T, SK Hynix A-Die)

- Grafikprozessor

- GeForce RTX 4080 (MSI VENTUS 3X OC)

- Display

- 2x Dell S2721DGF (WQHD) @ 144 Hz

- SSD

- Samsung 980 Pro 500 GB (Windows), Samsung 990 Pro 4 TB (Games), Samsung 980 Pro 2 TB (Games)

- Soundkarte

- Creative SoundBlaster X4, ASW Sonus DC70 @ Onkyo TX-8220, DT 770 Pro (250 Ohm), Logitech G432

- Gehäuse

- Fractal Design Define 7 XL (Dark Tempered Glass)

- Netzteil

- Seasonic Prime TX-850 + Seasonic 12VHPWR Kabel

- Keyboard

- Logitech G815 (GL Clicky)

- Mouse

- Logitech G502 X Lightspeed (schwarz) + Powerplay Mousepad

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox

- Sonstiges

- Samsung Galaxy S23 Ultra (12/512 GB, Phantom Black)

- Internet

- ▼270 MBit/s ▲43 MBit/s

Du meinst den Core Ultra 9 285K.

- Mitglied seit

- 03.10.2006

- Beiträge

- 15.314

- Ort

- Pampa

- Desktop System

- PSBOX

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Strix X670E-A

- Kühler

- EK Velocity

- Speicher

- Kingston Fury Renegade 64GB

- Grafikprozessor

- RTX 5090 incoming

- Display

- Asus Rog Swift PG32UCDM

- SSD

- M.2 1TB SIlicon M.2 980Pro 2TB M.2 980Pro 1TB

- Soundkarte

- Soundblaster G6 +HIFIman Arya+Endgear Microfon

- Gehäuse

- Lian Li O11 Vision Chrome Mora 420

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech G915

- Mouse

- G502

- Betriebssystem

- Win11 Pro

- Internet

- ▼100mbit

Den 9950X3D würde ich nur kaufen wen jeder CCD den eignen Cache hat und nicht wie es es beim 7950X3D gelöst wurde.Bin mal gespannt ob der 15900k wieder das ca. das doppelte kostet wie der 9800x3d und dabei langsamer im gaming ist. Oder der 9800x3d wieder schneller wie der 9950x3d bleibt.

Nozomu

Legende

- Mitglied seit

- 11.03.2011

- Beiträge

- 15.922

- Desktop System

- Raptorlake

- Details zu meinem Desktop

- Prozessor

- i9-14900K

- Mainboard

- ASUS PRIME Z690-P D4

- Kühler

- Noctua NH-D15 (3x NH-A15 Lüfter)

- Speicher

- 4x8GB 3866 MHz G.Skill Trident Z RGB (f4-3866c18d-16gtzr) (Samsung B-Die)

- Grafikprozessor

- ZOTAC GAMING GeForce RTX 4070 Twin Edge OC White Edition

- Display

- ASUS XG27UCS 27'' 3840 x 2160 160 Hz / Samsung 28" U28E850 3840 x 2160 60 Hz

- SSD

- System und mehr: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- HDD

- Spiele SSD: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- Gehäuse

- EVGA DG-87 (Lüfter= Front: 3x 140+2x 200 / TOP: 1x 200 / Heck: 4x 140 GPU 1x 140 )

- Netzteil

- EVGA SuperNOVA 850 T2 TITANIUM

- Betriebssystem

- Windows 11 Pro

Finger weg! Der gehört mirDu meinst den Core Ultra 9 285K.

Wollte schon immer zur Ultra Gruppe gehören

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Bringt es den überhaupt einen Vorteil? Beim gaming reichen doch 8. Dann leidet doch nur der VerbrauchDen 9950X3D würde ich nur kaufen wen jeder CCD den eignen Cache hat und nicht wie es es beim 7950X3D gelöst wurde.

Nozomu

Legende

- Mitglied seit

- 11.03.2011

- Beiträge

- 15.922

- Desktop System

- Raptorlake

- Details zu meinem Desktop

- Prozessor

- i9-14900K

- Mainboard

- ASUS PRIME Z690-P D4

- Kühler

- Noctua NH-D15 (3x NH-A15 Lüfter)

- Speicher

- 4x8GB 3866 MHz G.Skill Trident Z RGB (f4-3866c18d-16gtzr) (Samsung B-Die)

- Grafikprozessor

- ZOTAC GAMING GeForce RTX 4070 Twin Edge OC White Edition

- Display

- ASUS XG27UCS 27'' 3840 x 2160 160 Hz / Samsung 28" U28E850 3840 x 2160 60 Hz

- SSD

- System und mehr: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- HDD

- Spiele SSD: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- Gehäuse

- EVGA DG-87 (Lüfter= Front: 3x 140+2x 200 / TOP: 1x 200 / Heck: 4x 140 GPU 1x 140 )

- Netzteil

- EVGA SuperNOVA 850 T2 TITANIUM

- Betriebssystem

- Windows 11 Pro

Da musst du wahrscheinlich bis AM6 warten.Den 9950X3D würde ich nur kaufen wen jeder CCD den eignen Cache hat und nicht wie es es beim 7950X3D gelöst wurde.

- Mitglied seit

- 03.10.2006

- Beiträge

- 15.314

- Ort

- Pampa

- Desktop System

- PSBOX

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Strix X670E-A

- Kühler

- EK Velocity

- Speicher

- Kingston Fury Renegade 64GB

- Grafikprozessor

- RTX 5090 incoming

- Display

- Asus Rog Swift PG32UCDM

- SSD

- M.2 1TB SIlicon M.2 980Pro 2TB M.2 980Pro 1TB

- Soundkarte

- Soundblaster G6 +HIFIman Arya+Endgear Microfon

- Gehäuse

- Lian Li O11 Vision Chrome Mora 420

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech G915

- Mouse

- G502

- Betriebssystem

- Win11 Pro

- Internet

- ▼100mbit

Dann wird es halt ein 9800X3D da macht man es mir dann ganz Einfach und es gibt für mich nichts zum überlegen.Da musst du wahrscheinlich bis AM6 warten.

Zuletzt bearbeitet:

AreWeRlyFree

Experte

- Mitglied seit

- 06.03.2015

- Beiträge

- 614

Würde sich ein Upgrade vom 5800x3D lohnen? Ich vermute, das ist aktuell natürlich noch Kaffeesudleserei, oder?

G

Gelöschtes Mitglied 189335

Guest

Nachricht gelöscht

- Mitglied seit

- 13.04.2003

- Beiträge

- 4.447

- Desktop System

- Darki

- Details zu meinem Desktop

- Prozessor

- AMD 7800x3d

- Mainboard

- Asrock b650e Riptide Wifi

- Kühler

- Arctic Liquid Freezer III 280 A-RGB

- Speicher

- Kingston FURY Beast DIMM Kit 32GB @6000

- Grafikprozessor

- Gainward GeForce GTX 1070 Phoenix GS 8GB

- Display

- LG 34 Inch 21:9 UltraWide™ Gaming Monitor with G-Sync®

- SSD

- Western Digital WD_BLACK SN850X NVMe SSD 2TB, M.2

- Opt. Laufwerk

- ASUS BC-12D2HT Silent internes Blu-Ray Combo Laufwerk

- Gehäuse

- Fractal Design Define 7

- Netzteil

- be quiet! Straight Power 11 Platinum 650

- Keyboard

- Logitech Standard Keyboard

- Mouse

- Logitech Mx518

- Betriebssystem

- Windows 11pro

- Webbrowser

- Firefox

- Internet

- ▼Vf Gigabit

Ich würde mich natürlich freuen, kann aber auch sein das da nächstes Jahr nur noch ein refresh kommt und dann 26 27 nur so Perlen wie 9600x3d und 9700xt und co. Die nächste große gen würde dann wohl 26 bereits für am6 kommen. Oder am6 kommt wirklich sehr spät und wir sehen noch was nettes auf am5, gerne auch viele neue gute apus. Also abwarten.

Ansonsten genau der Grund warum ich nicht auf 13700k gegangen bin.

Ansonsten genau der Grund warum ich nicht auf 13700k gegangen bin.

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Hoffe es ist wie bei am4 eine mehr Generationen PlattformIch würde mich natürlich freuen, kann aber auch sein das da nächstes Jahr nur noch ein refresh kommt und dann 26 27 nur so Perlen wie 9600x3d und 9700xt und co. Die nächste große gen würde dann wohl 26 bereits für am6 kommen. Oder am6 kommt wirklich sehr spät und wir sehen noch was nettes auf am5, gerne auch viele neue gute apus. Also abwarten.

Ansonsten genau der Grund warum ich nicht auf 13700k gegangen bin.

Infi88

Urgestein

- Mitglied seit

- 09.09.2010

- Beiträge

- 2.392

- Ort

- Köln

- Desktop System

- Infi1337

- Laptop

- Jochen

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-13700KF

- Mainboard

- ASRock Z790 Taichi Carrara

- Kühler

- Noctua NH-D14

- Speicher

- G Skill F5-6400J3239G16G

- Grafikprozessor

- NVIDIA GeForce RTX 4080 SUPER

- Display

- Samsung Odyssey G7

- SSD

- Samsung SSD 990 Pro 2TB

- Gehäuse

- Silverstone Raven 2 (RV02-E)

- Netzteil

- Corsair AX860 80 PLUS Platinum

- Keyboard

- Corsair K95 RGB PLATINUM Cherry MX Speed

- Mouse

- Logitech G Pro X Superlight 2

- Betriebssystem

- Microsoft Windows 10 Professional 64-Bit

- Webbrowser

- Mozilla Firefox Beta

13700KF ist auch deutlich besser als der 13700K.

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Hmm Fehler in der Matrix

Vergleich die Daten vom 5000er x3d zum 7000er x3d.

Dann weißt du wie der 9000er x3d abschneiden wird.

Vergleich die Daten vom vom 5000er zum 7000er zum 9000er.Würde sich ein Upgrade vom 5800x3D lohnen? Ich vermute, das ist aktuell natürlich noch Kaffeesudleserei, oder?

Vergleich die Daten vom 5000er x3d zum 7000er x3d.

Dann weißt du wie der 9000er x3d abschneiden wird.

Zuletzt bearbeitet:

SkillerBehindYou

Enthusiast

- Mitglied seit

- 03.12.2011

- Beiträge

- 294

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- Asus ROG Crosshair VIII Hero Wi-Fi

- Kühler

- Noctua NH-D15 SE-AM4

- Speicher

- 4x8GB G.Skill Trident Z 3600-16 B-Die

- Grafikprozessor

- Gigabyte RTX3080 Eagle OC

- Display

- Acer XF270HUA

- SSD

- Samsung 970 Pro 512GB, WD BLACK SN750 2TB [...]

- Gehäuse

- Fractal Design Meshify 2 Grau TG

- Netzteil

- Corsair RM850i

- Keyboard

- Ducky One 3 TKL, MX-Speed-Silver

- Mouse

- Razer Viper V2 Pro

Geht wohl weniger um den Vorteil, sondern darum den Nachteil des unoptimierten OS scheduling zu umgehen - damit sichergestellt ist dass die spielethreads definitiv auf nem X3D chiplet laufen.Bringt es den überhaupt einen Vorteil? Beim gaming reichen doch 8. Dann leidet doch nur der Verbrauch

Oder ist das problem windows-seitig mittlerweile 100% gefixed? @all

Beitrag automatisch zusammengeführt:

würd mich in die reihe der uninformierten einreihen - hau mal deine infos raus biddeHmm Fehler in der Matrix

Vergleich die Daten vom vom 5000er zum 7000er zum 9000er.

Vergleich die Daten vom 5000er x3d zum 7000er x3d.

Dann weißt du wie der 9000er x3d abschneiden wird.

Kaleo Meow

Profi

5700x3D hier. davor 5600x, davor 3900x, davor 3600 davor 1800x.

Bereue es nicht. ♥

Denn mein uralter Traum wurde war, Echtzeitstrategiespiele laufen nun butterweich und das nicht nur in den ersten Minuten! XD

Bereue es nicht. ♥

Denn mein uralter Traum wurde war, Echtzeitstrategiespiele laufen nun butterweich und das nicht nur in den ersten Minuten! XD

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Meine Info war, dass die 9000er aka Zen5 16er CCX bekommen. Diese von mir fehlerhafte Info kannst du mehrfach im Forum lesen.würd mich in die reihe der uninformierten einreihen - hau mal deine infos raus bidde

Entsprechend hab ich eben noch mal google gefragt, Google sagt dass Zen5 8er CCX hat.

AMD’s next-gen Ryzen 9000 desktop chips and the Zen 5 architecture arrive in July

But AMD says AM4 will hang around for budget PCs well into 2025.

Zur Frage 9000er x3d:

Was der x3d kann, 5700x zu 5800x3d kann man nachlesen. 7700x zu 7800x3d kann man nachlesen. Dann weiß man was der x3d bringt.

Und dann hast du halt 15% vom 5000er zum 7000er und 16% vom 7000er zum 9000er. Oder anders: 16% mehr als der 7800x3d.

🤷♂️

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Stimmt nicht ganz oder AMD hat falsche Folien gezeigt. In den Folien ist zu sehen das der non 3d 10-20% schneller als der 14900k ist und dann wird der x3d nochmal 10-20% drauf setzten. Also bei cyberpunk ca 30% schneller und das Spiel ist keine Rosine.

Zur Frage 9000er x3d:

Was der x3d kann, 5700x zu 5800x3d kann man nachlesen. 7700x zu 7800x3d kann man nachlesen. Dann weiß man was der x3d bringt.

Und dann hast du halt 15% vom 5000er zum 7000er und 16% vom 7000er zum 9000er. Oder anders: 16% mehr als der 7800x3d.

🤷♂️

Anhänge

Zuletzt bearbeitet:

Niftu Cal

Enthusiast

- Mitglied seit

- 02.12.2018

- Beiträge

- 4.854

Gibt es hier wen der auf einen 5X3D gewechselt ist und in 4K spielt? Ich wünschte ich könnte mir den 5800X3D mal ausleihen, da ich gerne sehen würde ob der bei meinen Spielen irgendwas bringt. Vermutllich aber nix da die Spiele die ich spiele eh niemand testet und in 4K ist es recht wenig Unterschied. Vermutlich werde ich weiter warten und mir dann einen 8800X3D oder so holen. So 50 % in den min fps snd schon Minimum damit das Upgrade lohnt.

Ich habe den 5900X.

Ich habe den 5900X.

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Gibt es hier wen der auf einen 5X3D gewechselt ist und in 4K spielt?

[Guide] - Wie stellt man den idealen Gaming-PC zusammen?

Grundlagen: 1) Wie entsteht ein Bild im PC? Die meisten von Euch werden sicher irgendwann mal den Film "Matrix" von 1999 gesehen haben. Dort wird das Thema sehr schön und plastisch erklärt: Ne CPU schiebt grüne Zahlenkolonnen an die Grafikkarte, die Grafikkarte macht daraus ne hübsche Blondine...

Schau halt ob du im CPU Limit bist.

Schau nach ob deine Spiele auf den x3d reagieren.

Da brauchst du nix testen, ein wenig lesen und verstehen reicht.

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.328

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Lohnt sich nicht.Gibt es hier wen der auf einen 5X3D gewechselt ist und in 4K spielt? Ich wünschte ich könnte mir den 5800X3D mal ausleihen, da ich gerne sehen würde ob der bei meinen Spielen irgendwas bringt. Vermutllich aber nix da die Spiele die ich spiele eh niemand testet und in 4K ist es recht wenig Unterschied. Vermutlich werde ich weiter warten und mir dann einen 8800X3D oder so holen. So 50 % in den min fps snd schon Minimum damit das Upgrade lohnt.

Ich habe den 5900X.

Für WQHD oder weniger möglicherweise sonst nicht.

Für Strategie Spiele oder Aufbauspiele kann das durchaus in 4k nochmal impact haben, aber bei allem anderen eher weniger. Mein Fazit war das der Unterschied nüchtern irgendwo bei maximal 4% in 4k liegt im gemischten Szenario vs den anderen CPUs.

Der 5900x ist ja schon recht ordentlich bestückt mit Cache in combo mit Takt.

Was anderes wäre die Entscheidung von einer älteren Generation zu wechseln in AM4, dann wäreder X3D halt mit das Beste.

ZebuluXX

Enthusiast

- Mitglied seit

- 22.06.2012

- Beiträge

- 1.165

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MAG B650 Tomahawk WIFI

- Kühler

- ARCTIC Liquid Freezer II 360

- Speicher

- G.Skill RipJaws S5-6400J3239G32GX2-RS5K 64 GB

- Grafikprozessor

- Manli GeForce RTX® 4080 Gallardo

- Display

- LC Power LC-M40-UWQHD-144

- SSD

- Kingston SKC3000D/2048G

- Gehäuse

- Phanteks Eclipse P600s

- Netzteil

- Corsair RM Series RM850

- Keyboard

- Klim Domination

- Mouse

- Razor Basilisk V3

- Betriebssystem

- Windows 11 Pro

Für mich hat sich der Umstieg vom 5800X3D auf einen 7800X3D deutlich positiv bemerkbar gemacht, und zwar bei X-Plane und FS 2020 (und wahrscheinlich auch bei einigen anderen Games, die mir aber weniger wichtig und offenbar auch schon mit dem 5800X3D so ausreichend gut gelaufen sind, dass sie mir da nicht negativ aufgefallen sind).

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.328

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Das ist was anders, hier kommen nochmal fast 800mhz-1 Ghz Takt dazu und zusätzliche IPC (mehr Transistoren) on Top.Für mich hat sich der Umstieg vom 5800X3D auf einen 7800X3D deutlich positiv bemerkbar gemacht, und zwar bei X-Plane und FS 2020 (und wahrscheinlich auch bei einigen anderen Games, die mir aber weniger wichtig und offenbar auch schon mit dem 5800X3D so ausreichend gut gelaufen sind, dass sie mir da nicht negativ aufgefallen sind).

Bei Niftu Cals Beispiel handelt es sich um ein Wechsel von 5900x auf 5800X3D.

Der 5900x ist oder war vor Markteinführung vom 5800X3D quasi die schnellste CPU für Gaming die Sinnvoll war bei AM4 war, auch aufgrund des höheren Caches in Kombination mit höheren Taktspitzen.

Mittlerweile gibt es den 5700X3D noch, aber dieser ist höchsten interessant wenn man von einem 5600 oder 3700X/3600 oder älter kommt.

Ich kann nur so viel sagen den L3 Cache hatte mit dieser Generation AMD soweit nochmal optimiert das beide CCDs zugriff hatten und die Latenzen nochmal drastisch verkürzt wurden, klar ist das nicht so optimiert wie bei großzügigen X3D aber es hat trotzdem einen Effekt.

Kleiner Nachtrag So bald man sich in WQHD oder höheren Auflösungen bewegt macht nicht viel Sinn. In einigen Benchmarks mit 5800X3D @3200 vs 5800X3D @3800 mhz hat es nicht mal mehr eine skalierung gegeben. Das heißt wenn man sich noch am RAM geld sparen möchte lohnt sich das.

Wenn man aber schon einen 5900X hat sollte man schauen ob man stattdessen lieber am RAM nochmal optimieren kann. 100€ hier für ein flottes RAM Kit kann unter umständen das FPS Delta etwas reduzieren zum X3D.

Zuletzt bearbeitet:

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

CPU und Auflösung so in Relation zu setzen wie du es tust ist grundsätzlicher Quatsch.Kleiner Nachtrag So bald man sich in WQHD oder höheren Auflösungen bewegt macht nicht viel Sinn. In einigen Benchmarks mit 5800X3D @3200 vs 5800X3D @3800 mhz hat es nicht mal mehr eine skalierung gegeben. Das heißt wenn man sich noch am RAM geld sparen möchte lohnt sich das.

Mit einer 4090 im System ist deine Aussage heute schon falsch.

Es geht um CPU Limit und GPU Limit.

Wenn du im GPU Limit bist, wird ne neue CPU nix bringen.

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.328

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Ja und nein, wenn es ein Engine Limit ist erkennst du das nicht und eine Projektion auf neuartige Spiele kannst du auch nicht machen (voraussagen).CPU und Auflösung so in Relation zu setzen wie du es tust ist grundsätzlicher Quatsch.

Mit einer 4090 im System ist deine Aussage heute schon falsch.

Es geht um CPU Limit und GPU Limit.

Wenn du im GPU Limit bist, wird ne neue CPU nix bringen.

Aber alleine schon die Tests von HWUnboxed hatten gezeigt das Nvidia Treiber und AMD Treiber unterschiedlich in Limits skalieren.

Nvidia ist CPU hungriger im allgemeinen als AMD.

HW Unboxed Video

Leider werden zu selten Benchmarks in Limits gemacht.

Edit: Diese Anomalie kannst in den typischen Benchmarks nicht feststellen. Das ist immer auch so meine Kritik. Man nimmt immer die Schnellste CPU damit man potentiell kein CPU Bottleneck hat und lässt testen welche die Schnellste Grafikkarte ist: Check die 4090.

Alle anderen CPU Tests werden dann nur mit der 4090 gemacht, diese Tests reflektieren aber nach dem HW Unboxed Video aber nicht die real Performance mit einer AMD Karte oder Nvidia Karte einer älteren Generation in einem Bottleneck Szenario.

Wir gehen davon aus das Resultat aus der Nvidia Konstellation gilt auch für alle AMD Setups. Unter umständen kauft sich einer aber 7900GRE und hätte aber keinen X3D gebraucht weil das Scaling vom 7600 zum 7800X3D bei dieser Karte vielleicht nicht das 4090 Nvidia Delta repräsentiert.

Zuletzt bearbeitet:

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Was interessiert ein engine limit in einem CPU Benchmark?

Wenn du ne CPU testen willst brauchst du ein geeignetes Szenario für den Test. Ein künstliches nicht durch die CPU verursachtes Limit ist kein geeignetes Szenario.

Ich teste doch auch nicht einen Porsche GT3 mit angezogener Handbremse oder im Rückwärtsgang für ne Aussage über topspeed?

Wenn du ne CPU testen willst brauchst du ein geeignetes Szenario für den Test. Ein künstliches nicht durch die CPU verursachtes Limit ist kein geeignetes Szenario.

Ich teste doch auch nicht einen Porsche GT3 mit angezogener Handbremse oder im Rückwärtsgang für ne Aussage über topspeed?

Zuletzt bearbeitet:

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.328

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Okay dann erklär mir das HW Unboxed Resultat. Mit der Anomalie.Was interessiert ein engine limit in einem CPU Benchmark?

Ich teste doch auch nicht einen Porsche GT3 mit angezogener Handbremse oder im Rückwärtsgang für ne Aussage über topspeed?

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Was interessiert eine Anomalie durch Driver Overhead für eine generelle Aussage?Okay dann erklär mir das HW Unboxed Resultat. Mit der Anomalie.

Wenn du ne Anomalie testen willst, Teste die Anomalie. Aber auf Basis eines außergewöhnlichen Datenpunkt eine generelle Aussage mit vielen Datenpunkten in Frage zu stellen ist einfach dumm.

Die ganze Diskussion ist dumm, außer man will den Driver Overhead analysieren. Dann ist es evtl interessant.

Wer CPU Limit und GPU Limit nicht versteht und dann meint CPU Overhead mit einer halb so starken AMD Grafikkarte ausgleichen zu können und deswegen Quatsch kauft, dem kann ich auch nicht helfen.Wir gehen davon aus das Resultat aus der Nvidia Konstellation gilt auch für alle AMD Setups. Unter umständen kauft sich einer aber 7900GRE und hätte aber keinen X3D gebraucht weil das Scaling vom 7600 zum 7800X3D bei dieser Karte vielleicht nicht das 4090 Nvidia Delta repräsentiert.

Auch diesen Punkt halte ich für dumm.

Weil am Ende läuft's darauf hinaus dass du nach deiner Logik jede CPU mit jeder GPU und jedem Treiber der letzten 12 Monate und jedem Spielepatch der letzten 12 Monate testen musst.

Und dann hast du einen Haufen Daten, aber keine für Kaufberatungen sinnvolle Erkenntnis.

Dann kannst du auch einfach nach den Ranglisten und groben FPS werten kaufen und wissen dass das exakte Ergebnis durch Einfluss von Software, Kühlung und Konfigurationen variiert.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 44

- Aufrufe

- 3K

- Antworten

- 85

- Aufrufe

- 7K

D

- Antworten

- 21

- Aufrufe

- 2K

- Antworten

- 147

- Aufrufe

- 8K

D

- Antworten

- 750

- Aufrufe

- 48K