- Mitglied seit

- 15.11.2002

- Beiträge

- 27.495

Micron bestätigt Einsatz von GDDR6X auf der GeForce RTX 3090 - Hardwareluxx

Micron bestätigt Einsatz von GDDR6X auf der GeForce RTX 3090.

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

2k ok aber noch ein wasserblock backplate hmm das wird echt Zuviel. Auf Luft noch ok aber wer möchte so etwas.jo also wenn das Teil

384Bit, 19-21 GBps, 24GB, 5375 Cores, 2,X GHz Takt und 3x8 Pin hat dann lecko mio - das wird TEUER

also 1999-2499€ für den fetten sind es auf alle Fälle

... hängt von den Freiern ab, er scheint da ne echt gute Stelle zu haben.Kommt auf den Stundenlohn an.

Ne SLi lohnt nicht mehr und Titan brauche ich auch nicht.@Powerplay

Na dann hau mal rein!

meine Schmerzgrenze liegt bei 2000 Euronen; bei mehr warte ich auf Preissenkung;jo also wenn das Teil

384Bit, 19-21 GBps, 24GB, 5375 Cores, 2,X GHz Takt und 3x8 Pin hat dann lecko mio - das wird TEUER

also 1999-2499€ für den fetten sind es auf alle Fälle

Ich kaufe aber keine GPU mit toller P/L, sondern die billigste GPU mit der von mir benötigten leistung.

Ich lese auf den letzten Seiten hier viel zu oft etwas von 2.000EUR. Pssst, bringt niemanden auf Ideen *Spaß*

wie schon gesagt, für den Preis erwarte ich auch fast volle Austattung (nur 48 Gb Ram wären noch besser), sonst gehe ich nicht mitSehr ungünstige Strategie. Die werden sicherlich schon in Foren mitlesen und wenn da alle sagen "2000 bugs no problem", dann kommen auch die 2000 bugs...

yo, also 24 Gb VRam, 384 Bit SI, 5300 Cores, Raytracing 4mal effizienter als 2080 ti"fast volle Ausstattung" -> da muss ALLES passen.

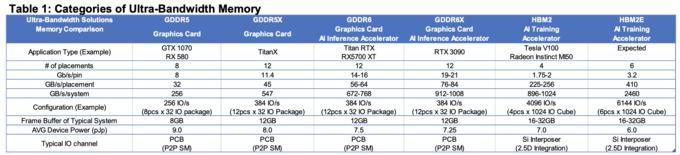

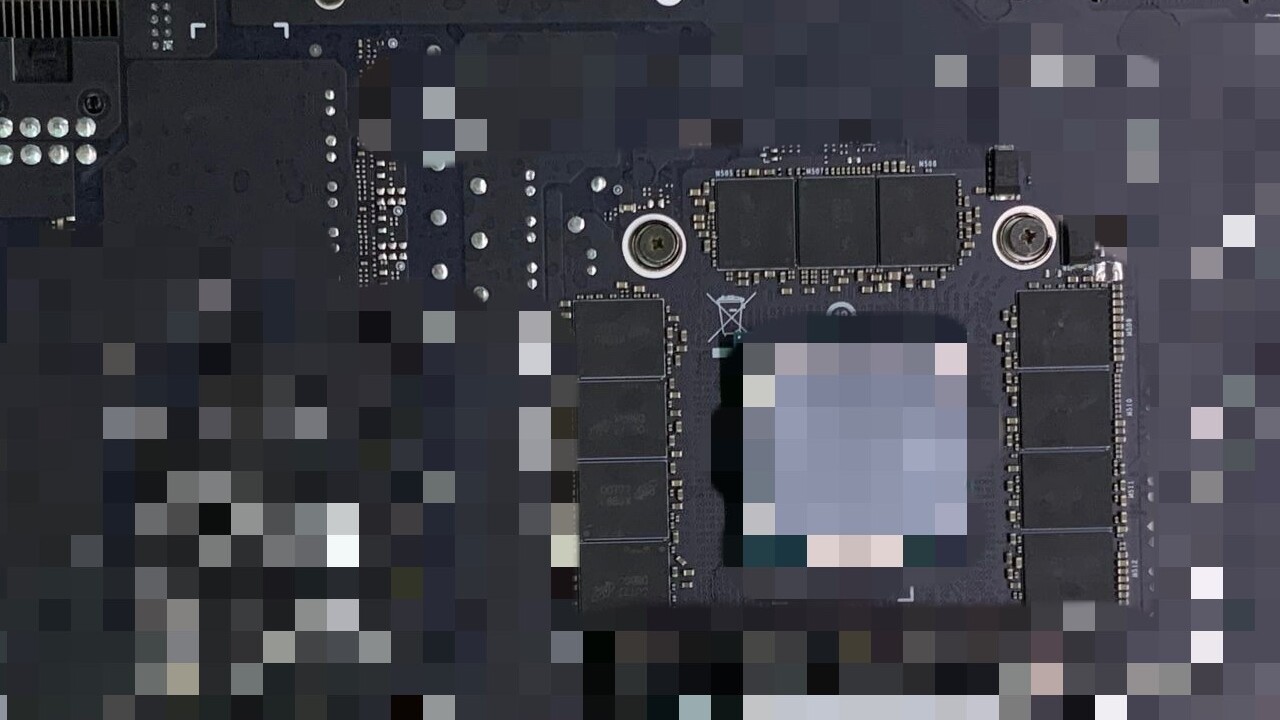

Zu sehen sind 11 GDDR6-Speichermodule, was für 22 GB Speicher sprechen würde – denn 11 Module auf der Rückseite bedeuten 11 weitere auf der Vorderseite. Der bekannte Leaker kopite7kimi ist sich jedoch sicher, dass der zwölfte Speicherbaustein verpixelt worden ist. Und mit 24 Bausteinen beziehungsweise 24 GB dürfte es sich demzufolge um die Platine einer GeForce RTX 3080 Ti oder RTX 3090(der genau Name ist noch unklar) handeln.

24 GB @ 21 und 5374 Cores - da kann BN einpacken, und selbst wenn die Karte 350W säuft, es kommt wenigstens was raus

Die Frage ist nur, was kommt bei rum?Sowas macht man nicht über Nacht. Dahinter steckt eine enorme Arbeitsleistung, die ich so bei AMD auch (noch) nicht sehe.