Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Alle Details zur neuen GeForce-RTX-Generation auf Ampere-Basis

- Ersteller HWL News Bot

- Erstellt am

Ich denke die 3090 wird beidseitig sein. Wenn man sich zB. die Custom Designs anschaut, pusten ja bei eigentlich allen Karten die hinteren Lüfter auf bzw. durch die Backplate. In Kombination mit der Wärmeableitung über die Backplate evtl ausreichend.

Igor erklärt die Welt, heute: Wie die verdopplung der CudaCores die Nvidia angibt zustande kommt:Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Dazu n paar kleine teaser auf die performance der karte (aka DF Zahlen sind kein kompletter Bullshit, aber schon Cherry Picking)

Vielen Dank für das Video! Ich bin eigentlich nicht so der Youtube Gucker, deshalb kannte ich Igor´s Lab bisher nur von der Website dazu.

Was für´n cooler Typ (bin auch fast so ein alter Sack *g*) und jetzt hab ich doch um einiges mehr verstanden was diese GPC, FP32 etc.

Geschichten angeht.

Also liege ich mit meinen Bedenken gar nicht so verkehrt. Fließkomma Berechnungen sind sicherlich wichtiger, aber wie sehr vielleicht gerade

Spiele die ich gerne zocke auf Int32-Berechnungen setzten...keine Ahnung.

Igor´s subtilem Grinsen nach zu urteilen wird man wohl in der Regel mit mindestens 50% Mehrleistung der 3080 ggü. der 2080ti rechnen

können (also wohl so ~70% zur 2080Super). Das wäre theoretisch ein guter Wert mit dem ich bei einer 700-800€ Grafikkarte leben könnte.

Ältere, oder andere nicht in Benchmark-Pakours berücksichtigte Spiele laufen ja meist auch auf den 2080er Karten schon problemlos auf 4k

mit 60Fps+, sollte Ampere da weniger Performancesteigerung bringen, wäre das wohl zu verschmerzen.

Ich sehe aufgrund dieser merkwürdigen Trickserei, schweren Herzens, dennoch vorerst von einem Kauf der 3080 ab. Das Nvidia wirklich behauptet

sie hätten die Kerne auf über 10k bzw. über 8k verdoppelt ist eine freche Marketing-Lüge und am Ende setzen 90% der PS5/XboxSX Ports vorallem

auf Int 32-Berechnungen und aus 80% Vorsprung in Doom Eternal werden 30% in Halo Inf. - wer weiß!? Da warte ich doch erstmal die AMD

Karten ab und vorallem erste Benchmarks von NextGen Portierungen.

coldfingers

Urgestein

- Mitglied seit

- 16.07.2005

- Beiträge

- 4.961

Was genau war denn schlecht an der ?

Man hörte die Motorengeräusche und die klangen wie ein Formel Eins Auto. Normalerweise rauschen Lüfter eher. Leise wäre evtl. OK gewesen aber das war so richtig laut. Dazu kam die Hitzeentwicklung mit 87 Grad in Division 1. Ich hatte mir bei der Kühler Konstruktion viel erhofft und wurde maßlos enttäuscht. Die Karte sah echt klasse aus und war top verarbeitet aber das alleine reicht halt nicht aus. Echt schade und seitdem halte ich nicht mehr soviel von Aourus.

Cippoli

Enthusiast

- Mitglied seit

- 09.08.2006

- Beiträge

- 5.071

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7900 (12C/24T)

- Mainboard

- ASUS ROG Strix B650E-E Gaming WiFi

- Kühler

- Noctua NH-U12A chromax.black + NA-HC7 chromax.black.swap

- Speicher

- G.Skill Trident Z5 Neo RGB DDR5-6000 (2x16GB Dual-Channel)

- Grafikprozessor

- Powercolor Red Devil 7900 XTX 24GB

- Display

- LG 65" C2 OLED TV

- SSD

- Samsung 990 Pro M.2 NVMe 2TB

- Soundkarte

- RME ADI-2 DAC

- Gehäuse

- be quiet! Pure Base 500 Window Black

- Netzteil

- be quiet! Dark Power 13 850W Titanium

- Keyboard

- Logitech G 810

- Mouse

- Logitech G Pro Gaming

- Betriebssystem

- Microsoft Windows 11 Enterprise

- Internet

- ▼1000 MBit ▲50 MBit

@Madschac

Als Trickserei oder nur Marketing würde ich es nicht bezeichnen wollen. Finde es schon noch akzeptabel die Einheiten verdoppelt anzugeben. Aus technischer Sicht ist das alles jedenfalls schon genial umgesetzt. Die Frage ist nur wie stark ein Game auf INT32-Berechnungen setzt. Ich denke, das wird man sich bei nVidia schon genau angeschaut haben.

Als Trickserei oder nur Marketing würde ich es nicht bezeichnen wollen. Finde es schon noch akzeptabel die Einheiten verdoppelt anzugeben. Aus technischer Sicht ist das alles jedenfalls schon genial umgesetzt. Die Frage ist nur wie stark ein Game auf INT32-Berechnungen setzt. Ich denke, das wird man sich bei nVidia schon genau angeschaut haben.

Mo3Jo3

Experte

- Mitglied seit

- 01.08.2017

- Beiträge

- 2.902

- Ort

- ganz im Westen

- Details zu meinem Desktop

- Prozessor

- 8700k@5Ghz

- Mainboard

- MSI Z370 Carbon

- Kühler

- Custom WaKü

- Speicher

- TridentZ 32Gb@3600

- Grafikprozessor

- 1080Ti

- Display

- PredatorX34

- SSD

- 960Pro

- Soundkarte

- FiiO K3

- Gehäuse

- InWin S-Frame

- Netzteil

- BQ Dark Power Pro11 550W

So wie es aussieht werden die Super/Ti Varianten mit 16 und 20GB nicht beidseitig bestückt, sondern mit neuen 16Gbit Chips.

www.heise.de

www.heise.de

GDDR6X-RAM: Speicherhersteller Micron verdoppelt 2021 die Kapazität

Die Hinweise auf eine GeForce RTX 3080 mit 20 GByte und eine GeForce RTX 3070 (Ti) mit 16 GByte RAM verdichten sich.

Dwayne_Johnson

Legende

- Mitglied seit

- 24.12.2009

- Beiträge

- 15.928

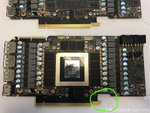

Sicher???Soll angeblich der 3080 Reference PCB sein.

Die Referenz-Karten sollten hinten doch diesen V-förmigen Ausschnitt haben, wegen dem Kühler

Ich habe mal folgende Aufteilung eines Frames in Control gefunden:

Da wird schon einiges an Int32 genutzt und so wie ich das verstanden habe bedeutet auch nur die geringste Nutzung von Int32-Berechnungen, das zurückfallen

der Architektur auf 64 FPS32 + 64 Int32, also auf genau die Werte von Turing. Damit kann eine 30x0 GPU ihr Leistungsplus in Control ausschließlich über die

RT Kerne und DLSS 2.0 und die Tensor Kerne generieren und natürlich über die gesteigerte Speicherperformance.

Bei der Turing Veröffentlichung hat Nvidia diesen Chart gezeigt:

Demnach scheinen die meisten aktuellen Spiele auch Int32-Berechnungen zu verwenden...

Ich hoffe, dass es dann vielleicht auch möglich ist statt 64 / 64 z.B. 30 Int32- / 98 FP32-Berechnungen durchführen zu können, ansonsten werden

wir 80% Mehrleistung wirklich nur in ganz wenigen ausgewählten Spielen sehen.

---edit---

Ahh, ich wurde gerade darauf hingewiesen, dass jede der SM Einheiten dann ja noch mal getrennt agieren kann. So könnte ein Teil im 64/64 Modus

auch Int32-Berechnungen durchführen, wärend der andere Teil die volle FP32 Power ausspielen kann.

Dann wäre das vorallem eine Frage der optimalen Treiber-Konfiguration, damit die Kerne wirklich so gut ausgelastet werden können. Da kann man

dann doch einiges an Hoffnung in Nvidia setzen, deren Treiber sind ja in der Regel recht ausgereift *daumen drückt*

Da wird schon einiges an Int32 genutzt und so wie ich das verstanden habe bedeutet auch nur die geringste Nutzung von Int32-Berechnungen, das zurückfallen

der Architektur auf 64 FPS32 + 64 Int32, also auf genau die Werte von Turing. Damit kann eine 30x0 GPU ihr Leistungsplus in Control ausschließlich über die

RT Kerne und DLSS 2.0 und die Tensor Kerne generieren und natürlich über die gesteigerte Speicherperformance.

Bei der Turing Veröffentlichung hat Nvidia diesen Chart gezeigt:

Demnach scheinen die meisten aktuellen Spiele auch Int32-Berechnungen zu verwenden...

Ich hoffe, dass es dann vielleicht auch möglich ist statt 64 / 64 z.B. 30 Int32- / 98 FP32-Berechnungen durchführen zu können, ansonsten werden

wir 80% Mehrleistung wirklich nur in ganz wenigen ausgewählten Spielen sehen.

---edit---

Ahh, ich wurde gerade darauf hingewiesen, dass jede der SM Einheiten dann ja noch mal getrennt agieren kann. So könnte ein Teil im 64/64 Modus

auch Int32-Berechnungen durchführen, wärend der andere Teil die volle FP32 Power ausspielen kann.

Dann wäre das vorallem eine Frage der optimalen Treiber-Konfiguration, damit die Kerne wirklich so gut ausgelastet werden können. Da kann man

dann doch einiges an Hoffnung in Nvidia setzen, deren Treiber sind ja in der Regel recht ausgereift *daumen drückt*

Zuletzt bearbeitet:

Cippoli

Enthusiast

- Mitglied seit

- 09.08.2006

- Beiträge

- 5.071

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7900 (12C/24T)

- Mainboard

- ASUS ROG Strix B650E-E Gaming WiFi

- Kühler

- Noctua NH-U12A chromax.black + NA-HC7 chromax.black.swap

- Speicher

- G.Skill Trident Z5 Neo RGB DDR5-6000 (2x16GB Dual-Channel)

- Grafikprozessor

- Powercolor Red Devil 7900 XTX 24GB

- Display

- LG 65" C2 OLED TV

- SSD

- Samsung 990 Pro M.2 NVMe 2TB

- Soundkarte

- RME ADI-2 DAC

- Gehäuse

- be quiet! Pure Base 500 Window Black

- Netzteil

- be quiet! Dark Power 13 850W Titanium

- Keyboard

- Logitech G 810

- Mouse

- Logitech G Pro Gaming

- Betriebssystem

- Microsoft Windows 11 Enterprise

- Internet

- ▼1000 MBit ▲50 MBit

Ahh, ich wurde gerade darauf hingewiesen, dass jede der SM Einheiten dann ja noch mal getrennt agieren kann. So könnte ein Teil im 64/64 Modus

auch Int32-Berechnungen durchführen, wärend der andere Teil die volle FP32 Power ausspielen kann.

Dann wäre das vorallem eine Frage der optimalen Treiber-Konfiguration, damit die Kerne wirklich so gut ausgelastet werden können. Da kann man

dann doch einiges an Hoffnung in Nvidia setzen, deren Treiber sind ja in der Regel recht ausgereift *daumen drückt*

Ja, genau. Das ist dann alles eine Frage wie genau man das steuert und die Auslastung innerhalb der GPCs/SMs verteilt.

Würde das auch nur eingeschränkt trickserei nennen... Immerhin kommuniziert nvidia das alles vor launch klar und imho detaillierter als sie es müssten

Und da das nda ebenfalls vor launch fällt (imho noch ein Zeichen für gute Performance) und man eh nich pre ordern kann kein Risiko

Und da das nda ebenfalls vor launch fällt (imho noch ein Zeichen für gute Performance) und man eh nich pre ordern kann kein Risiko

- Mitglied seit

- 03.12.2006

- Beiträge

- 3.691

- Ort

- MTK

- Details zu meinem Desktop

- Prozessor

- 13700K

- Mainboard

- MSI Z790 Tomahawk

- Kühler

- Arctic Liquid Freezer II 360

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 32GB, DDR5-6400, CL32-39-39-102

- Grafikprozessor

- INNO3D GeForce RTX 4090 X3 OC

- Display

- LG UltraGear 38GL950G-B

- SSD

- Gigabyte AORUS 1TB, 2x860EVO, 1x980pro 1TB

- Gehäuse

- Corsair 7000D Airflow schwarz, Glasfenster

- Netzteil

- ROG-THOR-1200P2-GAMING

- Keyboard

- Ducky Shine 7

- Mouse

- Corsair Nightsword RGB + Corsair MM350 Champion

- Betriebssystem

- Win 11pro 64bit

- Sonstiges

- Backforce one plus

- Internet

- ▼400 ▲200

ja, habe ich auch schon spekuliert, aber dann wäre die Aussage, dass ab dem 17.Sep erhältlich ja umsonst

[https://www.hardwareluxx.de/communi...s-ampere-und-gtx-30-series-deep-dive.1276662/

Ab wann wir euch mit eigenen Test versorgen können, bleibt zunächst einmal noch ein Geheimnis. Die GeForce RTX 3080 wird ab dem 17. September erhältlich sein. Die GeForce RTX 3090 folgt am 24. September. Spätestens an diesen Tagen ist mit den Tests zu rechnen.]

Ab dem 14.Sep gibt es alle Infos, hat ja hwluxx auch schon in einem Artikel angedeutet. Dann hat man wenigstens zum Verkaufsstart schon eine grobe Idee von dem, was man da eigentlich kauft.

[https://www.hardwareluxx.de/communi...s-ampere-und-gtx-30-series-deep-dive.1276662/

Ab wann wir euch mit eigenen Test versorgen können, bleibt zunächst einmal noch ein Geheimnis. Die GeForce RTX 3080 wird ab dem 17. September erhältlich sein. Die GeForce RTX 3090 folgt am 24. September. Spätestens an diesen Tagen ist mit den Tests zu rechnen.]

Ab dem 14.Sep gibt es alle Infos, hat ja hwluxx auch schon in einem Artikel angedeutet. Dann hat man wenigstens zum Verkaufsstart schon eine grobe Idee von dem, was man da eigentlich kauft.

Youngtimer

Urgestein

- Mitglied seit

- 25.10.2011

- Beiträge

- 2.961

Sicher???

Die Referenz-Karten sollten hinten doch diesen V-förmigen Ausschnitt haben, wegen dem Kühler

So sieht das neue Referenz Design aus. Gut zu erkennen an der Kerbe hinter dem PCIe Slot und dem 2x8pin Stromanschluss. Die Einsteiger Karten wie z.B. Gigabyte Eagle setzen da fast alle drauf. https://videocardz.net/gigabyte-geforce-rtx-3080-10gb-eagle-oc

Ein passender Wasserblock wäre z.B. dieser hier von EK. https://www.ekwb.com/shop/ek-quantum-vector-rtx-3080-3090-d-rgb-nickel-plexi

- Mitglied seit

- 03.12.2006

- Beiträge

- 3.691

- Ort

- MTK

- Details zu meinem Desktop

- Prozessor

- 13700K

- Mainboard

- MSI Z790 Tomahawk

- Kühler

- Arctic Liquid Freezer II 360

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 32GB, DDR5-6400, CL32-39-39-102

- Grafikprozessor

- INNO3D GeForce RTX 4090 X3 OC

- Display

- LG UltraGear 38GL950G-B

- SSD

- Gigabyte AORUS 1TB, 2x860EVO, 1x980pro 1TB

- Gehäuse

- Corsair 7000D Airflow schwarz, Glasfenster

- Netzteil

- ROG-THOR-1200P2-GAMING

- Keyboard

- Ducky Shine 7

- Mouse

- Corsair Nightsword RGB + Corsair MM350 Champion

- Betriebssystem

- Win 11pro 64bit

- Sonstiges

- Backforce one plus

- Internet

- ▼400 ▲200

Waere Sie nicht, ein prorder bei nem game ist ja auch noch kein release.

Erhältlich ist doch wann verschickt wird ?

ja, könnte sein

derSpalter

Banned

- Mitglied seit

- 16.06.2019

- Beiträge

- 472

- Desktop System

- PC

- Details zu meinem Desktop

- Prozessor

- Intel i7 10700K

- Mainboard

- MSI MPG Z490 GAMING PLUS

- Kühler

- NZXT Kraken X63 280 mm

- Speicher

- Crucial Ballistix BL2K8G36C16U4W 3600 MHz

- Grafikprozessor

- Zotac GTX1080

- Netzteil

- 750 Watt be quiet! Straight Power 11 Modular 80+ Gold

- Keyboard

- CORSAIR K95 Platinum

- Mouse

- Logitech G Pro Wireless

- Betriebssystem

- Windows 10 Home

Mit jedem Tag der vergeht werde ich unsicherer und frage mich brauch ich die 3090 eigentlich? Jetzt bin ich sogar schon unsicher bei der 3080 wegen dem gefühlt zu kleinen Speicher.

Es wäre besser gewesen sie hätten mich direkt vorbestellen lassen. Da hätten sie safe mein Geld gehabt. Aber bis zum 17 bin ich wahrscheinlich komplett geheilt.

Es wäre besser gewesen sie hätten mich direkt vorbestellen lassen. Da hätten sie safe mein Geld gehabt. Aber bis zum 17 bin ich wahrscheinlich komplett geheilt.

sweetchuck

Enthusiast

- Mitglied seit

- 14.08.2014

- Beiträge

- 1.426

Sicher???

Die Referenz-Karten sollten hinten doch diesen V-förmigen Ausschnitt haben, wegen dem Kühler

Nee. Das Referenz-PCB ist nicht das mit dem V (welches von der FE benutzt wird), sondern eines mit nem klassischen Rechteck.

Je mehr man über sinnloses Luxuszeugs nachdenkt, desto verrückter kommt einem der ganze Hype vor.

Was ist denn nun das Referenzlayout?

Ein direktes Vergleichsbild wäre top.

Meint ihr das der Kühler der Founders schlechter ist als der einer Strix beispielsweise?

Was ist denn nun das Referenzlayout?

Beitrag automatisch zusammengeführt:

Nee. Das Referenz-PCB ist nicht das mit dem V (welches von der FE benutzt wird), sondern eines mit nem klassischen Rechteck.

Ein direktes Vergleichsbild wäre top.

Meint ihr das der Kühler der Founders schlechter ist als der einer Strix beispielsweise?

- Mitglied seit

- 03.12.2006

- Beiträge

- 3.691

- Ort

- MTK

- Details zu meinem Desktop

- Prozessor

- 13700K

- Mainboard

- MSI Z790 Tomahawk

- Kühler

- Arctic Liquid Freezer II 360

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 32GB, DDR5-6400, CL32-39-39-102

- Grafikprozessor

- INNO3D GeForce RTX 4090 X3 OC

- Display

- LG UltraGear 38GL950G-B

- SSD

- Gigabyte AORUS 1TB, 2x860EVO, 1x980pro 1TB

- Gehäuse

- Corsair 7000D Airflow schwarz, Glasfenster

- Netzteil

- ROG-THOR-1200P2-GAMING

- Keyboard

- Ducky Shine 7

- Mouse

- Corsair Nightsword RGB + Corsair MM350 Champion

- Betriebssystem

- Win 11pro 64bit

- Sonstiges

- Backforce one plus

- Internet

- ▼400 ▲200

Ja, mir kam gestern wieder der Gedanke, für was man hier eigentlich sein Geld ausgibt. Und die Zeit um einen release nehme ich immer so war, als ob man gerade vor dem Freizeitpark morgens beim Aufmachen steht und dann gleich zum dicksten Fahrgeschäft rennt, um ja der erste in der Schlange zu sein.

- Mitglied seit

- 03.12.2006

- Beiträge

- 3.691

- Ort

- MTK

- Details zu meinem Desktop

- Prozessor

- 13700K

- Mainboard

- MSI Z790 Tomahawk

- Kühler

- Arctic Liquid Freezer II 360

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 32GB, DDR5-6400, CL32-39-39-102

- Grafikprozessor

- INNO3D GeForce RTX 4090 X3 OC

- Display

- LG UltraGear 38GL950G-B

- SSD

- Gigabyte AORUS 1TB, 2x860EVO, 1x980pro 1TB

- Gehäuse

- Corsair 7000D Airflow schwarz, Glasfenster

- Netzteil

- ROG-THOR-1200P2-GAMING

- Keyboard

- Ducky Shine 7

- Mouse

- Corsair Nightsword RGB + Corsair MM350 Champion

- Betriebssystem

- Win 11pro 64bit

- Sonstiges

- Backforce one plus

- Internet

- ▼400 ▲200

Meint ihr das der Kühler der Founders schlechter ist als der einer Strix beispielsweise?

Die Preisfrage...ich hoffe, dass so eine Frage auch am 14.Sep schon beantwortet werden kann

Nochmal Kurz:

Das PCB mit dem V schnitt ist die FE und gibts nur direkt bei Nvidia, Praktisch deren eigene Custom Lösung.

Das eckige PCB mit 2x8 Pin ist das Referenz Layout für die Partnerkarten.

Alles klar.

Die Preisfrage

Preisfrage?

- Mitglied seit

- 03.12.2006

- Beiträge

- 3.691

- Ort

- MTK

- Details zu meinem Desktop

- Prozessor

- 13700K

- Mainboard

- MSI Z790 Tomahawk

- Kühler

- Arctic Liquid Freezer II 360

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 32GB, DDR5-6400, CL32-39-39-102

- Grafikprozessor

- INNO3D GeForce RTX 4090 X3 OC

- Display

- LG UltraGear 38GL950G-B

- SSD

- Gigabyte AORUS 1TB, 2x860EVO, 1x980pro 1TB

- Gehäuse

- Corsair 7000D Airflow schwarz, Glasfenster

- Netzteil

- ROG-THOR-1200P2-GAMING

- Keyboard

- Ducky Shine 7

- Mouse

- Corsair Nightsword RGB + Corsair MM350 Champion

- Betriebssystem

- Win 11pro 64bit

- Sonstiges

- Backforce one plus

- Internet

- ▼400 ▲200

Preisfrage?

"Quizfrage", "die alles entscheidende Frage" (oder wie auch immer) ...nicht auf den Preis bezogen

Tech Enthusiast

Enthusiast

- Mitglied seit

- 01.01.2016

- Beiträge

- 3.609

- Desktop System

- PC

- Laptop

- Surface

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 - 5950X

- Mainboard

- Asus Dark Hero x570

- Kühler

- Noctua NH D15

- Speicher

- 32gb - Vengeance 3200

- Grafikprozessor

- PNY RTX 4090

- Display

- 4-eckig

- SSD

- 2tb Samsung 970 Evo

- Gehäuse

- Define zu alt

- Netzteil

- Asus Thor 850W

- Betriebssystem

- Windows 10

- Webbrowser

- Chrome

- Internet

- ▼1150 MBit ▲54 MBit

Und doch auch ne Preisfrage, wenn die Strix nicht zu 1499 zu haben sein wird, die FE aber schon. ;-)

Ähnliche Themen

- Antworten

- 709

- Aufrufe

- 46K

- Antworten

- 98

- Aufrufe

- 5K

- Antworten

- 198

- Aufrufe

- 14K

- Antworten

- 33

- Aufrufe

- 6K

- Antworten

- 518

- Aufrufe

- 28K